我为什么觉得 Diffusion Models 有趣?

文章讨论了 Diffusion LLM (dLLM) 的新颖之处。与传统 LLM 逐个预测 tokens 的方式不同,dLLM 同时启动所有步骤,逐步生成文本,在代码生成方面表现更优,速度和效率也更高。作者认为 dLLM 能够减少 LLM 产生的“幻觉”问题,先生成关键部分并验证,再生成其余部分。此外,dLLM 有助于改进多步骤 agent 工作流,避免陷入循环,通过提前规划确保整体一致性。文章还提供了体验 dLLM 的链接。

Diffusion models 很有趣

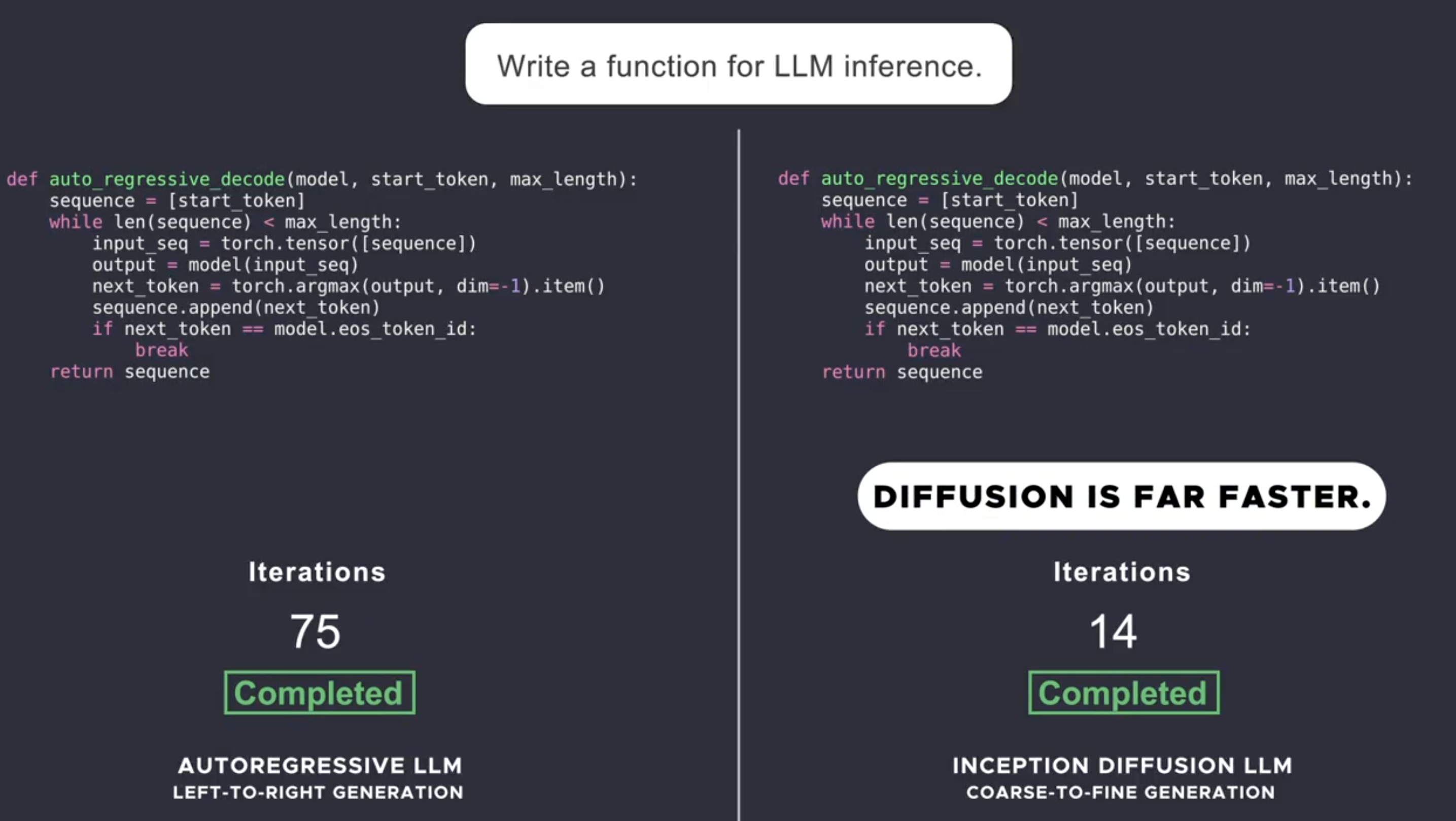

大约一周前,我偶然看到了这条 推文,一家名为 Inception Labs 的公司发布了一个 Diffusion LLM (dLLM)。它不像传统的 LLM 那样自回归地从左到右预测 tokens,而是同时启动所有步骤,然后逐步生成有意义的词(开始/结束/中间等)。这种曾经在图像和视频模型中有效的方法,现在在代码生成方面优于类似大小的 LLM。

- 该公司还声称在速度和效率方面提高了 5-10 倍。

为什么它们对我来说很有趣?

在过去两年多的时间里,我一直在阅读、写作和从事 LLM 评估工作,我看到了这种范式的一些显而易见的好处:

传统 LLM 会产生幻觉 (hallucinate)。 它们就像在自信地胡编乱造文本,同时还在编造事实。这就是为什么它们有时会非常自信地开始一个句子,但最终却提出了一个愚蠢的建议。 dLLM 可以首先生成某些重要的部分,验证它们,然后再继续生成其余的部分。

- 例如:一个客户服务 (CX) 聊天机器人会首先生成策略版本号,在就可能出现幻觉的策略向客户提供建议之前对其进行验证。

Agents 可能会变得更好。 使用 dLLM,多步骤的 agent 工作流可能不会陷入循环。 规划、推理和自我纠正 agent 流程的关键组成部分,而我们目前可能由于 LLM 架构而受到瓶颈。 dLLM 可以通过确保从上到下整个计划保持一致来解决这个问题。 这就像在未来提前看到一点(基于您拥有的任何上下文),然后确保您不会陷入困境。

这是一个更近期的模型 对我提出的“解释博弈论 (Explain Game theory)” 提示的响应。 您可以注意到句子的最后一部分是在中间部分之前生成的。 运行一些查询并查看首先生成哪些词是很有趣的。

您可以在 HF 上亲自尝试。

2025 年 3 月 6 日 · Diffusion, evals, dLLMs, agents, hallucination