尝试在 Mac 上运行 Mlx-community/OLMo-2-0325-32B-Instruct-4bit 模型

文章介绍了在 Mac 上使用 `llm-mlx` 插件运行 `mlx-community/OLMo-2-0325-32B-Instruct-4bit` 模型的方法。该模型宣称性能优于 GPT3.5-Turbo 和 GPT-4o mini。文章提供了安装模型的命令,以及通过命令行进行交互式聊天和生成 SVG 图像的示例。作者成功运行了该模型,并展示了生成的图像。

Simon Willison’s Weblog

mlx-community/OLMo-2-0325-32B-Instruct-4bit (via) OLMo 2 32B 宣称 自己是 "首个完全开放的模型 (所有数据、代码、权重和细节都免费提供),其性能优于 GPT3.5-Turbo 和 GPT-4o mini"。 感谢 MLX 项目,这里有一个我成功在 Mac 上运行它的方法,通过我的 llm-mlx 插件。

安装模型:

llm install llm-mlx

llm mlx download-model mlx-community/OLMo-2-0325-32B-Instruct-4bit

这会将 17GB 的数据下载到 ~/.cache/huggingface/hub/models--mlx-community--OLMo-2-0325-32B-Instruct-4bit。

启动与 OLMo 2 的交互式聊天:

llm chat -m mlx-community/OLMo-2-0325-32B-Instruct-4bit

或者运行一个提示:

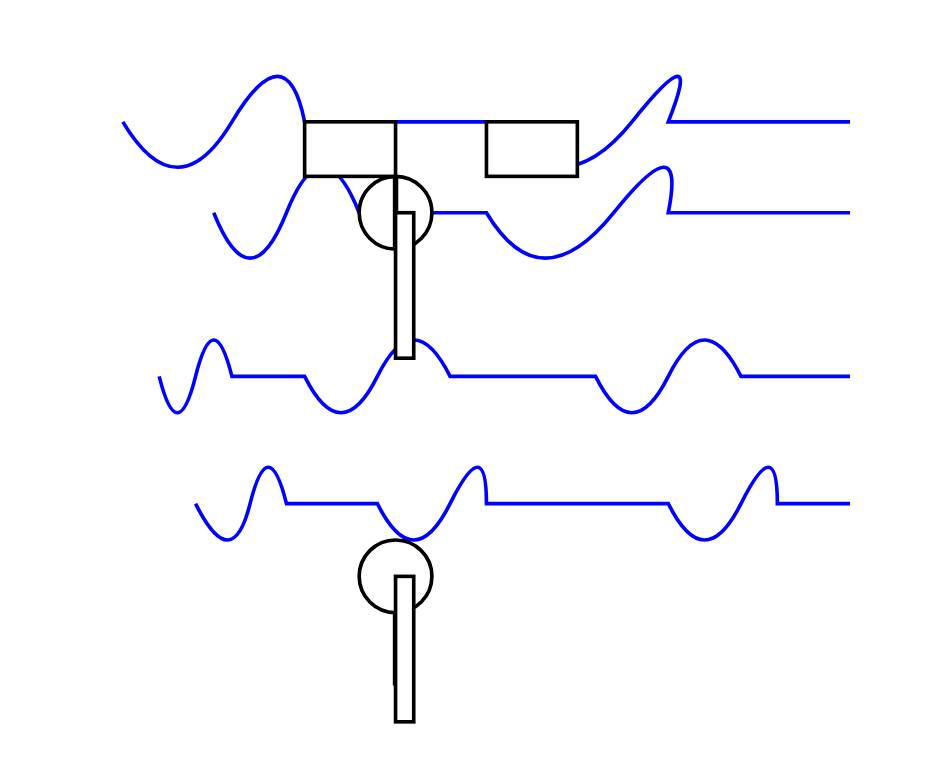

llm -m mlx-community/OLMo-2-0325-32B-Instruct-4bit 'Generate an SVG of a pelican riding a bicycle' -o unlimited 1

-o unlimited 1 移除了输出 tokens 数量的上限 - llm-mlx 的默认值是 1024,这不足以尝试绘制一个鹈鹕。

它绘制的鹈鹕 令人耳目一新地抽象:

Posted 16th March 2025 at 3:30 am

Recent articles

- Adding AI-generated descriptions to my tools collection - 13th March 2025

- Notes on Google's Gemma 3 - 12th March 2025

- Here's how I use LLMs to help me write code - 11th March 2025

llm 154 generative-ai 994 mlx 14 ai2 5 ai 1156 llms 983 pelican-riding-a-bicycle 19