AI 公司正在攻击 FOSS 基础设施

AI 公司正在攻击 FOSS 基础设施:LLM 爬虫的威胁

LLM 爬虫正在摧毁 FOSS 项目的基础设施,情况变得越来越糟。 , 和 Niccolò Venerandi 2025 年 3 月 20 日. 上午 11:27 9 分钟阅读

目录

三天前,SourceHut 的创始人兼 CEO Drew DeVault 发表了一篇名为《请停止将你的成本直接转嫁到我脸上》的博文,抱怨 LLM 公司在不遵守 robots.txt 协议的情况下爬取数据,给 SourceHut 造成了严重的故障。

我觉得“有意思!”,然后就过去了。

然后,昨天早上,KDE 的 GitLab 基础设施被另一个 AI 爬虫淹没,这些 IP 来自阿里巴巴的 IP 段;这导致 KDE 开发者暂时无法访问 GitLab。

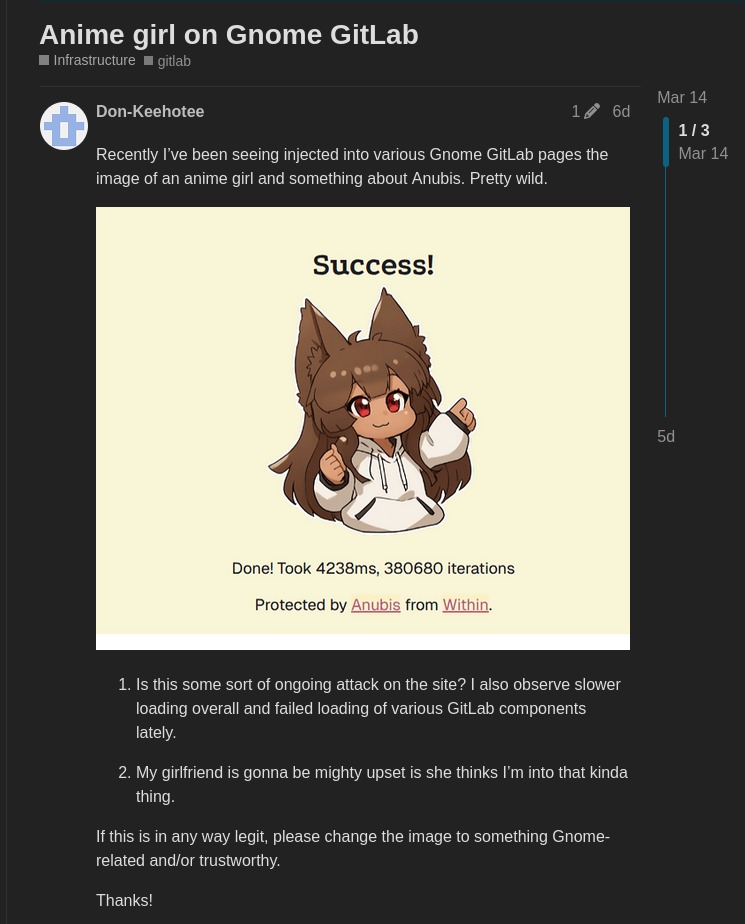

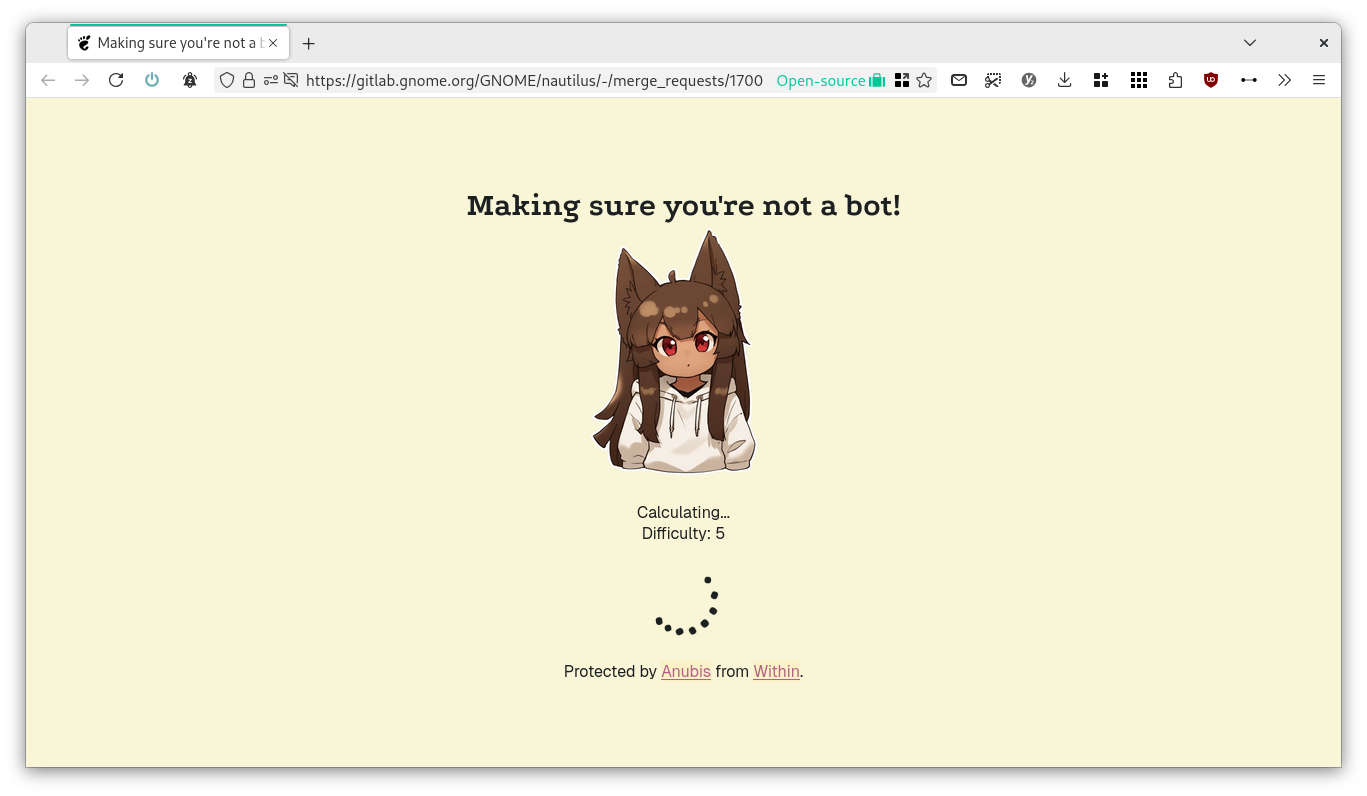

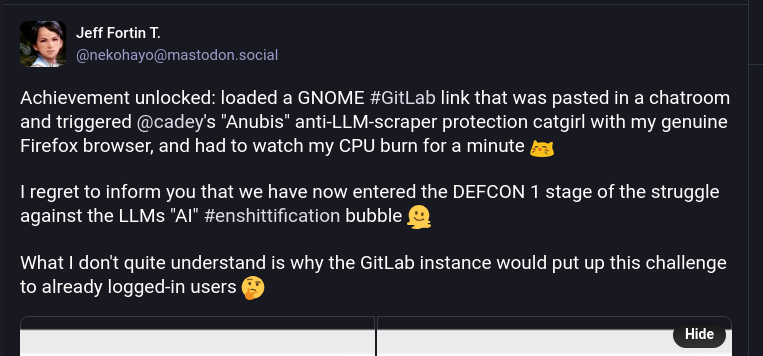

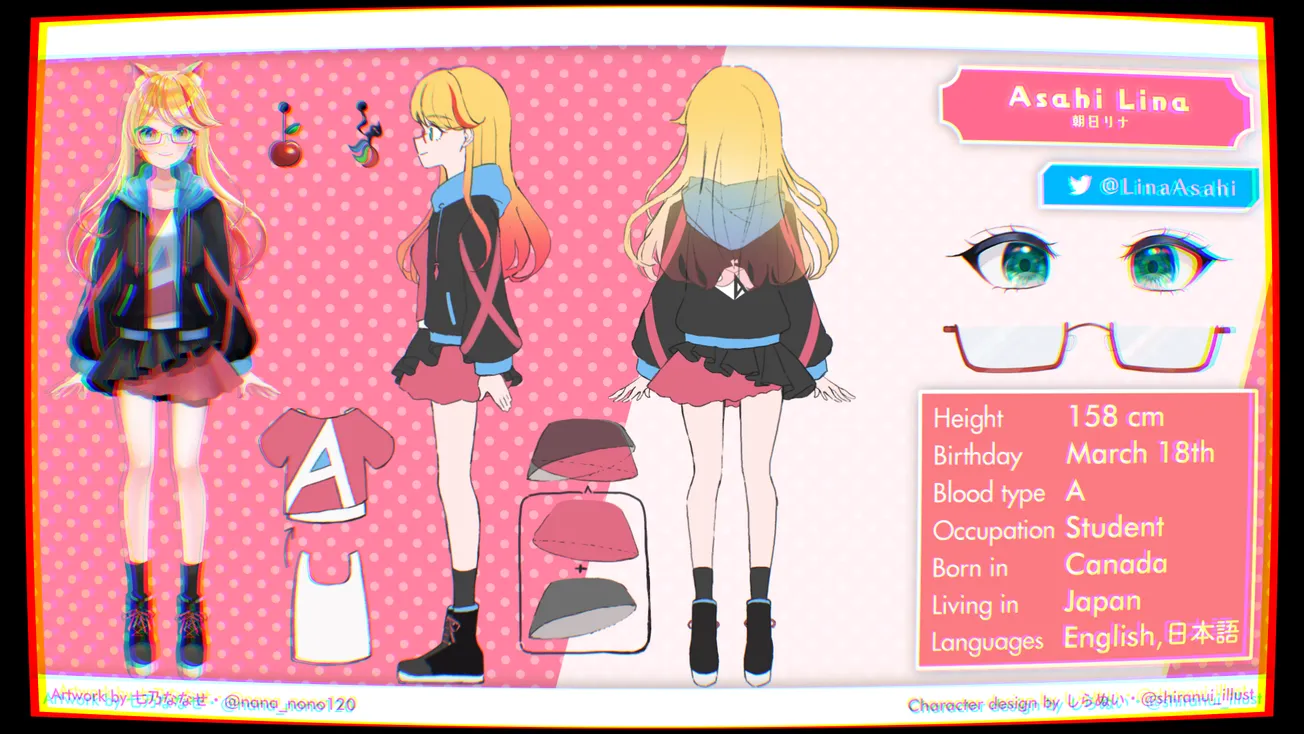

接着我发现,一周前,一个动漫女孩开始出现在 GNOME 的 GitLab 实例上,随着页面加载而出现。 事实证明,这是 Anubis 的默认加载页面,Anubis 是一种工作量证明挑战,旨在阻止导致中断的 AI 爬虫。

现在,很明显这绝非巧合。 AI 爬虫变得越来越激进,并且由于 FOSS 软件依赖于公开协作,而私营公司没有这种要求,因此这给开源社区带来了一些额外的负担。

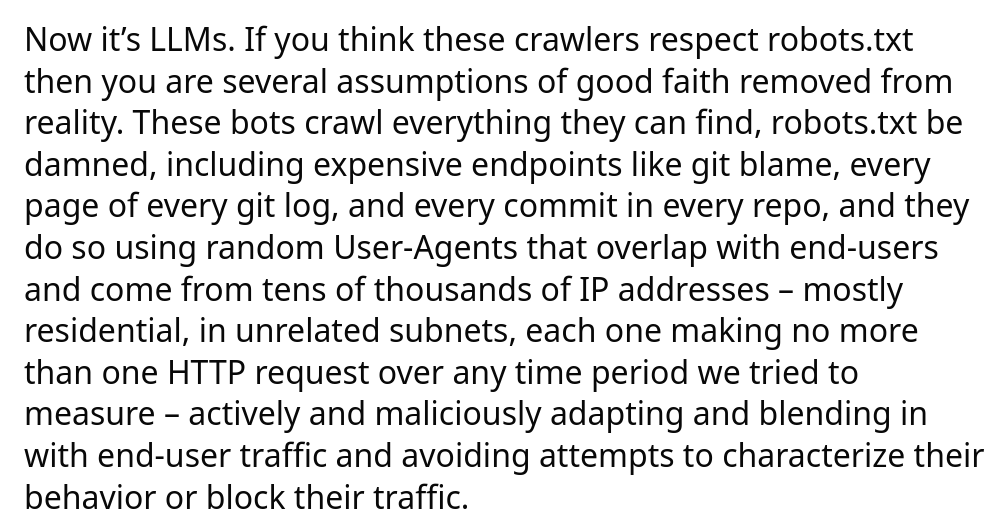

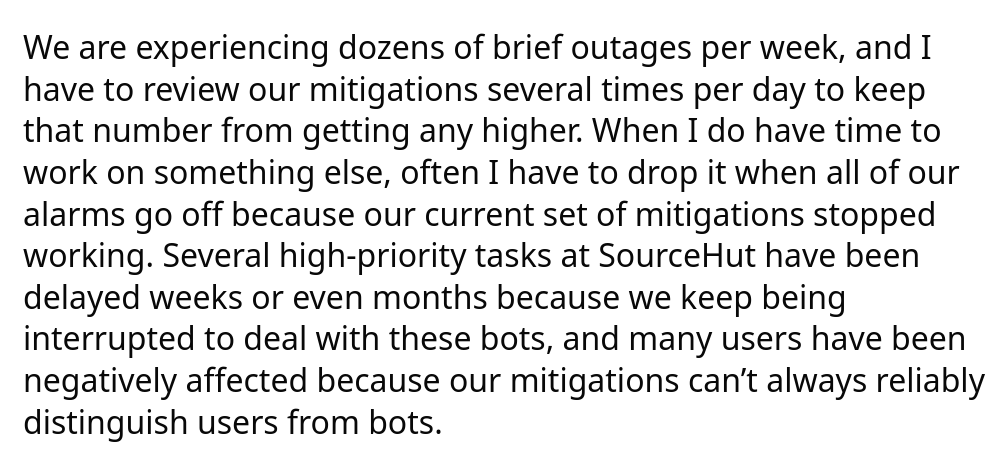

因此,让我们尝试获取更多详细信息——回到 Drew 的博文。 根据 Drew 的说法,LLM 爬虫不遵守 robots.txt 协议要求,并且会访问开销很大的端点,例如 git blame、每个 git 日志的每一页以及存储库中的每个提交。 他们使用来自数万个 IP 地址的随机 User-Agents 执行此操作,每个 IP 地址发出的 HTTP 请求不超过一个,试图与用户流量混淆。

因此,很难想出一个好的缓解措施。 Drew 说,由于这些中断,几个高优先级任务已经被推迟了数周或数月,用户偶尔会受到影响(因为很难区分机器人和人类),当然,这会导致 SourceHut 偶尔出现中断。

Drew 在这里没有区分哪些 AI 公司更尊重 robots.txt 文件,或者在他们的 user agent 报告中更准确; 稍后我们将能够对此进行更多研究。

最后,Drew 指出这并非孤立的问题。 他说:

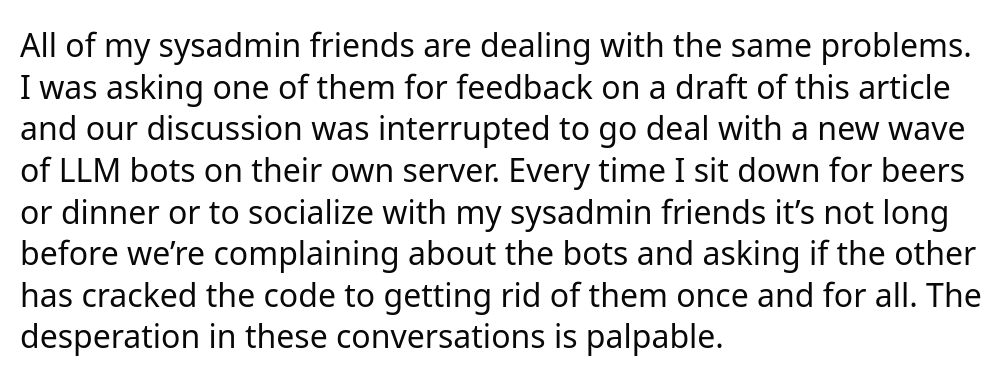

我所有的系统管理员朋友都在处理同样的问题,[并且]每次我坐下来喝啤酒或与系统管理员朋友共进晚餐进行社交时,我们很快就会抱怨这些机器人。[...] 这些对话中的绝望是显而易见的。

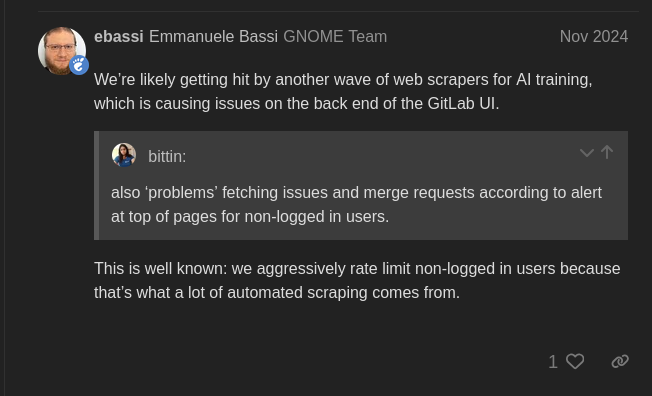

这让我想起了昨天 KDE GitLab 的问题。 根据 KDE 系统管理团队成员 Ben 的说法,执行此 DDoS 的所有 IP 都声称自己是 MS Edge,并且来自中国的 AI 公司; 他提到,像 OpenAI 和 Anthropic 这样的西方 LLM 运营商至少设置了正确的 UA - 稍后会详细介绍。

目前的解决方案是禁止这些机器人声称使用的 Edge 版本,尽管很难相信这将是一个最终的解决方案; 这些机器人似乎热衷于更改 user agent 以尽可能地融入其中。

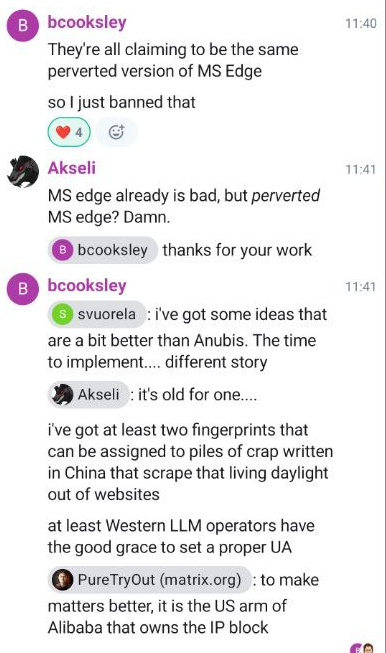

事实上,GNOME 自去年 11 月以来一直遇到问题; 作为临时解决方案,他们限制了未登录用户查看合并请求和提交的权限,这显然也给真正的访客造成了问题。

他们最终确定的解决方案是切换到 Anubis。 这是一个向浏览器提出挑战的页面,浏览器必须花费时间进行一些数学运算并将解决方案返回给服务器。 如果正确,您就可以访问该网站。

根据开发人员的说法,该项目“有点像核弹反应,但是 AI 爬虫如此积极地抓取迫使我不得不这样做。 我讨厌我必须这样做,但这就是我们为现代互联网付出的代价,因为机器人不符合诸如 robots.txt 之类的标准,即使它们声称符合”。

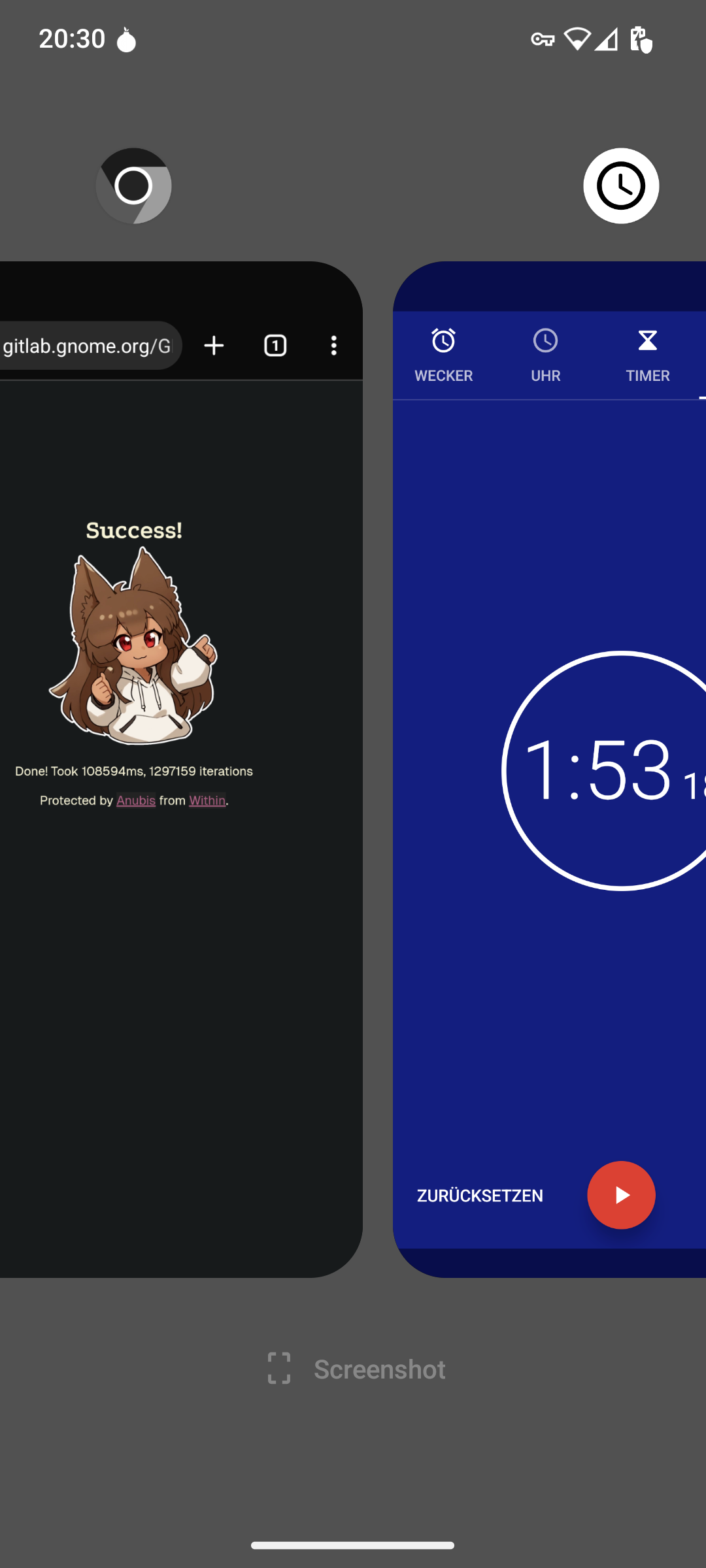

但是,这也导致了用户问题。 当很多人从同一个地方打开链接时,他们可能会得到一些难度较高的练习,这需要一些时间才能完成; 有一个用户报告说延迟了一分钟,另一个用户(从他的手机)不得不等待大约两分钟。

为什么? 嗯,一个 GitLab 链接被粘贴到一个聊天室里! 同样,当 Triple Buffering GNOME 合并请求发布到 Hacker News 时,也发生了同样的情况,因此在那里受到了很多关注。 正如开发人员所说,这对爬虫来说是一个核弹选项,但它也对人类造成了影响。

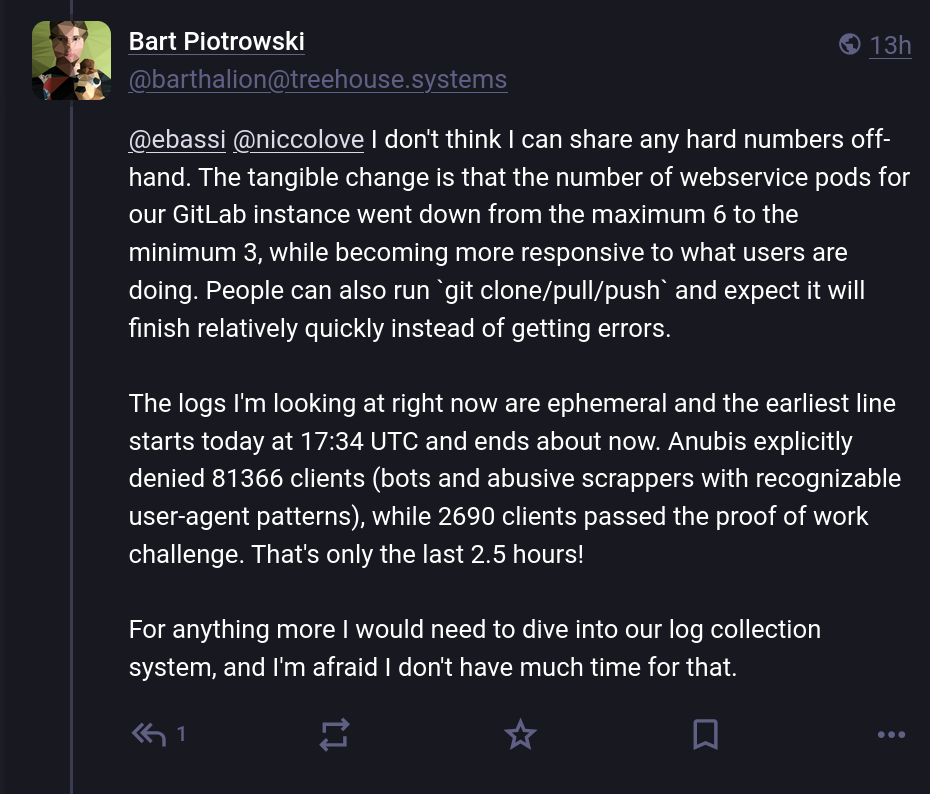

在 Mastodon 上,一位 GNOME 系统管理员 Bart Piotrowski 慷慨地分享了一些数字,让人们充分了解问题的范围。 据他说,在大约两个半小时内,他们收到了总共 8.1 万个请求,其中只有 3% 通过了 Anubis 的工作量证明,这表明 97% 的流量是机器人 - 一个疯狂的数字!

也就是说,至少 那 有效。 其他组织在处理这些爬虫时遇到了困难。

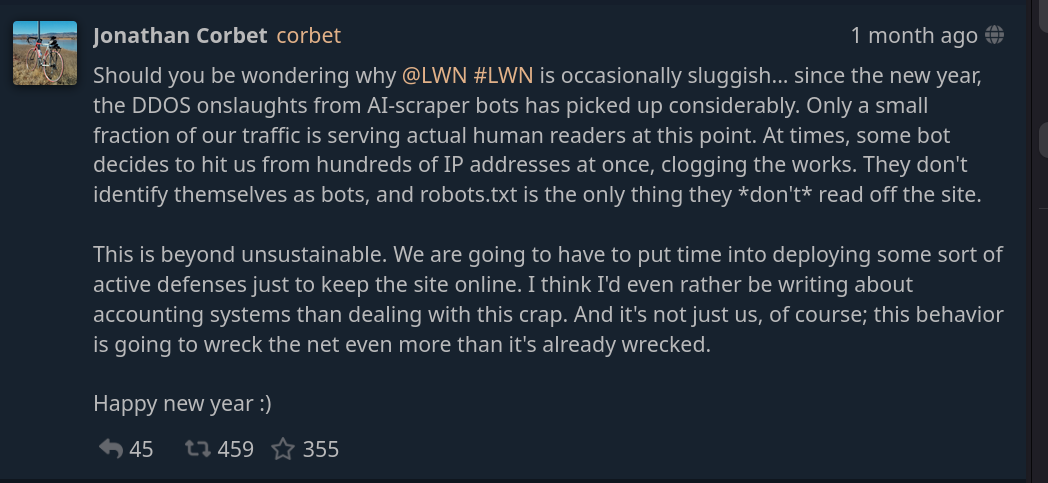

例如,这是 Jonathan Corbet,他运营着 FOSS 新闻来源 LWN,警告用户该网站可能“偶尔运行缓慢”…… 这是由于 AI 爬虫机器人的 DDoS 攻击。 他声称“只有一小部分流量是为实际人类读者服务的”,并且在某些时候,机器人“决定一次从数百个 IP 地址攻击我们。[...] 他们没有将自己标识为机器人,并且 robots.txt 是他们唯一没有从网站上读取的内容”。

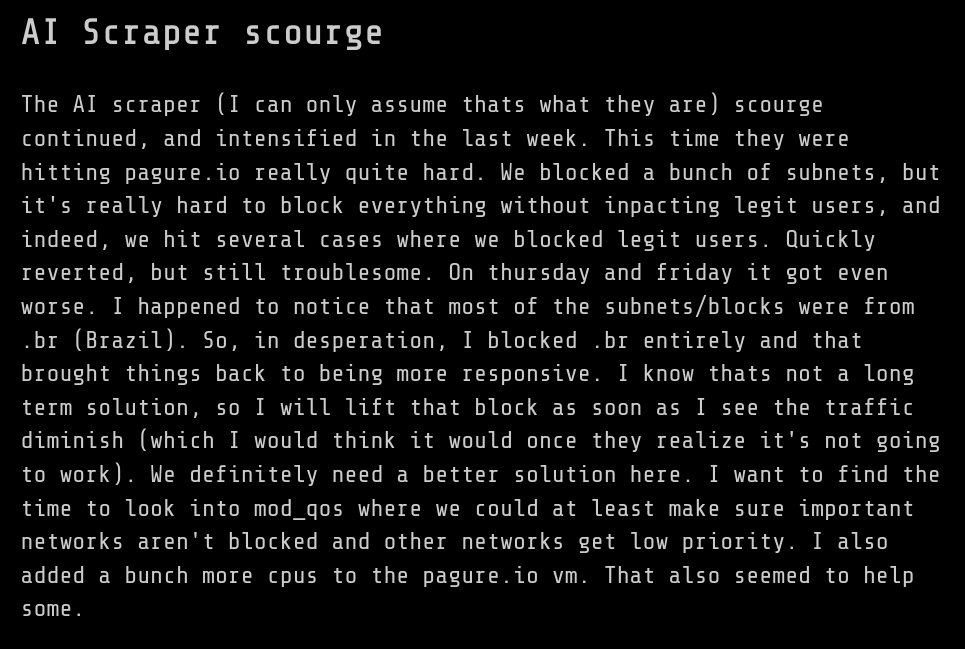

许多人表示声援,包括 Fedora 项目的系统管理员 Kevin Fenzi。 他们也遇到了 AI 爬虫的问题:首先,一个月前,他们不得不努力维持 pagure.io 的正常运行:

然而,随着时间的推移,情况变得 更糟,因此他们不得不阻止一堆子网,这也影响了许多真实用户。 由于绝望,Kevin 曾一度决定禁止整个巴西国家才能使事情再次运转; 据我所知,这项禁令仍然有效,并且不太清楚在哪里可以找到更长期的解决方案。

而且,正如 Neal Gompa 所指出的那样,即使阻止整个国家也只能解决这么多问题,而且显然 Fedora 基础设施由于 AI 爬虫而“已经定期瘫痪了数周”。

_最近一周_受到此问题影响的另一个项目是 Inkscape。 根据 Martin Owens 的说法,这不是“去年通常来自中国的 DDoS 攻击,而是来自一群公司,他们开始忽略我们的 spider conf 并开始欺骗他们的浏览器信息。 我现在有一个 Prodigius 阻止列表。 如果您碰巧在一家大型 AI 公司工作,您可能无法再访问我们的网站”。

嗯,Martin 并不是唯一一个构建“prodigious 阻止列表”的开发人员。 即使是来自 Frama 软件的 BigGrizzly 也被一个糟糕的 LLM 爬虫淹没,并构建了一个包含 46 万个具有欺骗性 user agent 的 IP 地址的列表以进行禁止; 他愿意分享该列表。

一个更全面的尝试是 “ai.robots.txt” 项目,这是一个与 AI 公司相关的网络爬虫的开放列表。 它们提供了一个实现 Robots Exclusion Protocol 的 robots.txt 文件,以及一个 .htaccess 文件,当收到来自其列表中任何 AI 爬虫的请求时,该文件将返回一个错误页面。

如果我们将时间倒退几个月,我们可以获得有关爬虫的更多数据。 这是 Dennis Schubert 关于 Diaspora(一个开源的去中心化社交网络)基础设施的一篇文章,他在其中说“查看流量日志让他非常生气”。

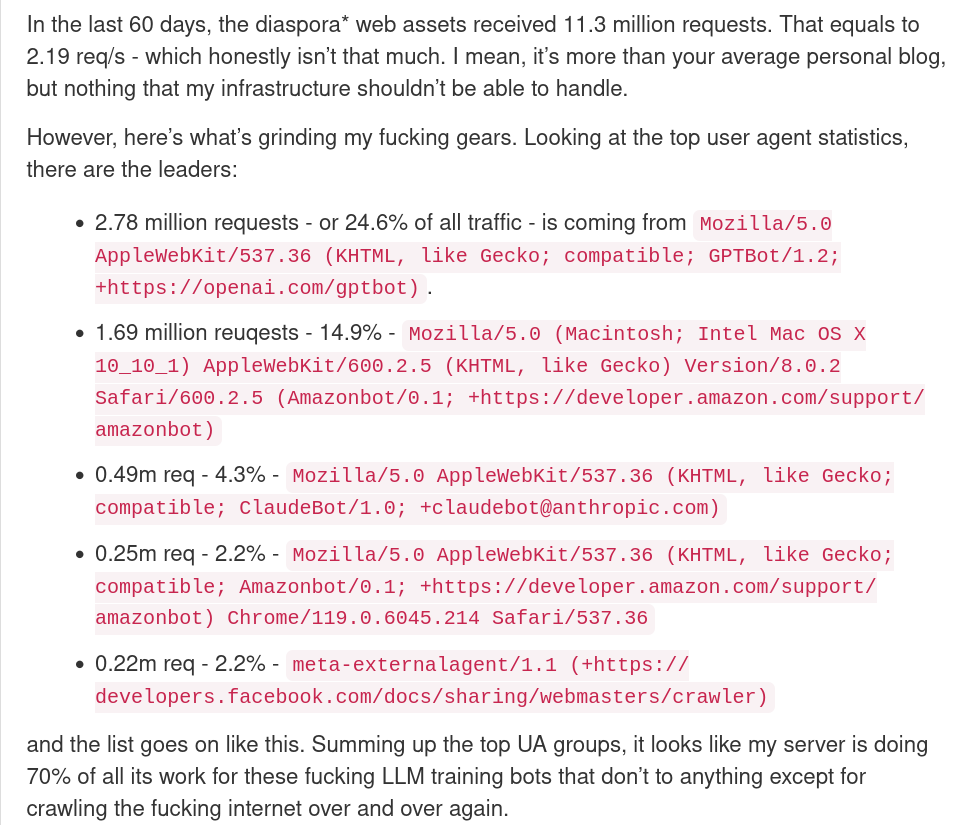

在该博文中,他声称他的整个网络流量的四分之一是由于具有 OpenAI user agent 的机器人造成的,15% 是由于 Amazon 造成的,4.3% 是由于 Anthropic 造成的,依此类推。 总的来说,我们谈论的是整个请求的 70% 来自 AI 公司。

据他说,

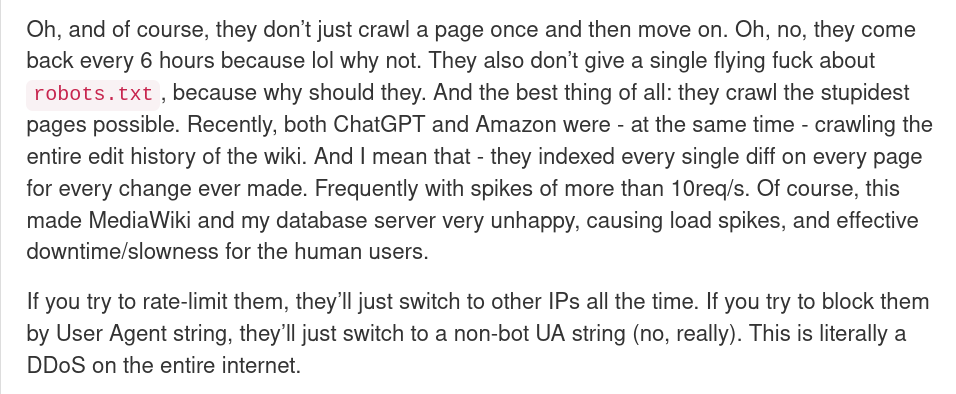

他们不仅仅是爬取一次页面然后离开。 哦,不,他们每 6 个小时回来一次,因为哈哈,为什么不呢。 他们也不关心

robots.txt,因为他们为什么要关心。[...] 如果您尝试对它们进行速率限制,它们将始终切换到其他 IP。 如果您尝试按 User Agent 字符串阻止它们,它们将切换到非机器人 UA 字符串(不,真的)。 这实际上是对整个互联网的 DDoS 攻击。

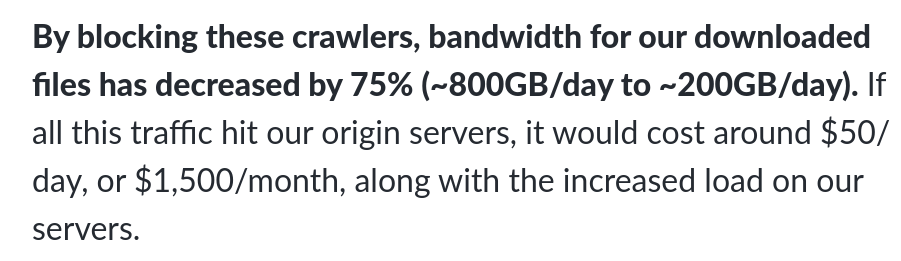

Read the Docs 项目给出了类似的数字。 在一篇名为“AI 爬虫需要更加尊重”的博文中,他们声称阻止_所有_ AI 爬虫立即将其流量减少了 75%,从每天 800GB 减少到每天 200GB。 这使得该项目每月节省约 1500 美元。

文章的其余部分也非常令人印象深刻; 他们谈论了爬虫在几天或更长时间内下载了数十 TB 的数据。 很难完全阻止它们,因为它们使用各种不同的 IP。

我想知道其中有多少是用于训练数据的抓取,又有多少是大多数 LLM 提供的“搜索”功能; 尽管如此,根据 Schubert 的说法,“正常”的爬虫(例如 Google 和 Bing 的爬虫)加起来只占不到一个百分点,这表明其他公司确实在滥用其网络权力。

但不仅仅是爬虫,否则我会将标题命名为“AI 爬虫”,而不是“AI 公司”。 开源社区一直在与之作斗争的另一个问题是 AI 生成的错误报告,例如。

Curl 项目的 Daniel Stenberg 首先在一篇名为“LLM 中的 I 代表 Intelligence”的博文中对此进行了报道。 Curl 提供了一个漏洞赏金项目,但最近,他们注意到许多错误报告是由 AI 生成的。 这些看起来很可信,并且需要开发人员花费大量时间进行检查,但它们也包含您期望从 AI 获得的典型幻觉。

因为一个错误报告自信地告诉您存在一些关键的安全问题需要修复,所以不得不检查自己的代码,这真是太疯狂了…… 但却没有找到它,因为整个问题只是 AI 幻觉。

CPython、pip、urllib3、Requests 等安全报告分类团队的 Seth Larson 也报告了类似的问题。 他说,

最近,我注意到开源项目收到的极低质量、垃圾邮件和 LLM 幻觉安全报告有所增加。 问题在于,在 LLM 时代,这些报告乍一看似乎是潜在的合法报告,因此需要花费时间来反驳。

这是一个非常大的问题。 正如他所指出的那样,响应安全报告的成本很高,而响应编造但可信的错误报告会对维护人员造成一些严重的额外负担,这可能会将他们赶出开源世界。

文章以一个请求结束:请不要使用 AI 或 LLM 系统来检测漏洞。 他说:“今天的这些系统无法理解代码,发现安全漏洞需要理解代码,并且需要理解人类层面的概念,例如意图、常见用法和上下文。”

再次,我想指出的是,这些问题对 FOSS 世界的影响不成比例; 开源项目不仅通常比商业产品的资源少,而且由于它们是社区驱动的项目,因此它们的更多基础设施是公开的,因此容易受到爬虫和 AI 生成的错误报告或问题的影响。

评论

相关文章

Why I recommend against Bluesky

Have you ever heard of the term federation-washing?

, 和 Niccolò Venerandi

2025 年 3 月 18 日

Open Source World

Open Source World

How I do articles and videos

, 和 Niccolò Venerandi

2025 年 3 月 10 日

Open Source World

Open Source World

So, what is open source, really?

, 和 Luca Bramè

2025 年 2 月 26 日

Open Source World

Open Source World

Would you pay for Free Software?

, 和 Luca Bramè 2025 年 2 月 20 日

最新文章

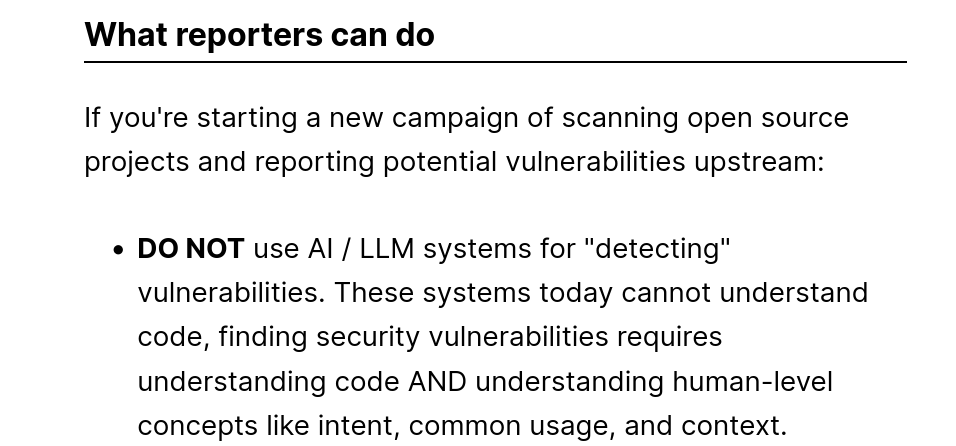

Asahi Lina pauses Apple GPU development, gets doxxed

, 和 Niccolò Venerandi

2025 年 3 月 19 日

Social Networks

Social Networks

Why I recommend against Bluesky

Have you ever heard of the term federation-washing?

, 和 Niccolò Venerandi

2025 年 3 月 18 日

Interviews

Interviews

How VeronicaExplains makes videos

, 和 Niccolò Venerandi

2025 年 3 月 15 日

Desktops

Desktops

KDE Board Member Nate Graham announces for-profit company

, 和 Niccolò Venerandi 2025 年 3 月 12 日