ARC-AGI-2 及 ARC Prize 2025 重磅回归

作者:Greg Kamradt

发布时间:2025年3月24日

作者:Greg Kamradt

发布时间:2025年3月24日

ARC-AGI-2 + ARC Prize 2025 is Back

提升水平,达到 AGI

优秀的 AGI 基准测试可以作为有用的进度指标。更好的 AGI 基准测试能够清晰地辨别能力。最好的 AGI 基准测试不仅做到以上所有,还能积极地激励研究和指导创新。

在 ARC Prize,我们的使命是通过持久的基准测试,作为通往 AGI 的北极星,将努力导向具有通用智能并显著缩短科学突破时间表的系统。

自 2019 年以来,ARC-AGI-1 一直在衡量 AGI 的进展,并且是唯一一个精确地指出 2024 年末 AI 超越纯粹记忆的确切时刻的基准测试。OpenAI 使用 ARC-AGI-1 来展示其 o3 系统的这一进展,该系统结合了基于深度学习的 LLMs 与推理合成引擎。

ARC Prize 2024 激励了数千名独立的学生和研究人员与前沿实验室合作,研究新的测试时适应想法。

但要达到 AGI,还有更多工作要做。AGI 仍然需要新的想法。

我们可以将像 o3 这样的系统描述为在流体智力领域中从“零到一”。但这些系统的效率非常低,并且目前在训练过程中需要大量的人工监督才能适应新的领域。

公告

今天,我们很高兴推出 ARC-AGI-2 来挑战新的前沿。ARC-AGI-2 对 AI(特别是 AI 推理系统)来说更难,同时对人类保持了相对的容易程度。纯 LLMs 在 ARC-AGI-2 上的得分为 0%,公共 AI 推理系统仅获得个位数的百分比分数。相比之下,ARC-AGI-2 中的每个任务都已由至少 2 个人在不到 2 次尝试中解决。

与此同时,今天我们宣布ARC Prize 2025(本周将在 Kaggle 上线),旨在推动开源在能够击败 ARC-AGI-2 的高效、通用系统方面的进展。

对人类容易,对 AI 困难

所有其他 AI 基准测试都侧重于超人能力或专业知识,通过测试 "PhD++" 技能。ARC-AGI 是唯一一个采取相反设计选择的基准测试——通过专注于对人类相对容易,但对 AI 来说困难或不可能的任务,我们突出了那些不会从 "scaling up" 中自发出现的capability gap。

ARC Prize Foundation 将此改编为我们衡量 AGI 的定义:人类容易而 AI 困难的任务集之间的差距。当这个差距为零时,当没有剩余的任务时,我们可以找到挑战 AI 的方法,我们将实现 AGI。

解决这些capability gap需要新的见解和新想法。重要的是,ARC-AGI 的存在不仅仅是为了衡量 AGI 的进展。它还旨在激励研究人员研究新想法。

智能需要从有限的经验中进行泛化,并将知识应用于新的、意想不到的情况。AI 系统在许多特定领域(例如,玩 Go 和图像识别)已经具有超人的能力。然而,这些是狭隘的、专门的能力。"human-ai gap" 揭示了通用智能所缺少的——高效地获得新技能。

Introducing ARC-AGI-2

ARC-AGI-2 基准测试今天发布。ARC-AGI 系列的第二个版本提高了 AI 的难度,同时保持了对人类的相同相对容易程度。

在对数百名人类参与者进行的受控研究中,每个 ARC-AGI-2 任务都由至少 2 个人在 2 次或更少的尝试中解决。这与我们为 AI 设定的规则相匹配,AI 每个任务获得两次尝试机会。

ARC-AGI-1 于 2019 年推出,旨在挑战深度学习。具体来说,它旨在抵抗简单地“记住”训练数据集的能力。ARC-AGI 包括一个训练数据集和几个评估集,包括一个用于 ARC Prize 2024 竞赛的私有评估集。训练集旨在教授解决评估集中的任务所需的核心知识先验。要解决评估任务,AI 系统必须展示基本的流体智力或适应新的、前所未见的任务的能力。

作为一个类比,可以将训练集视为学习小学数学符号的一种方式,而评估集要求您使用您对这些符号的知识来解决代数方程。你不能仅仅通过记忆来获得答案,你必须将现有知识应用于新问题。

任何能够击败 ARC-AGI-1 的 AI 系统都表现出二元水平的流体智力。相比之下,ARC-AGI-2 显着提高了 AI 的标准。要击败它,您必须表现出_高度的适应性和高效率_。

在设计 ARC-AGI-2 时,我们研究了前沿 AI 推理系统的这些属性。以下是一些示例任务,用于说明我们发现的一些内容。以下所有任务都是 ARC-AGI-2 的一部分,并且 (1) 在不到 2 次尝试中由至少 2 个人解决,并且 (2) 未被任何前沿 AI 推理系统解决。

注意:特别感谢 ARC Prize 社区对该分析的贡献,包括 Mace, Mikel, 以及 ARC Prize Discord 中的许多成员。

对 AI 仍然困难

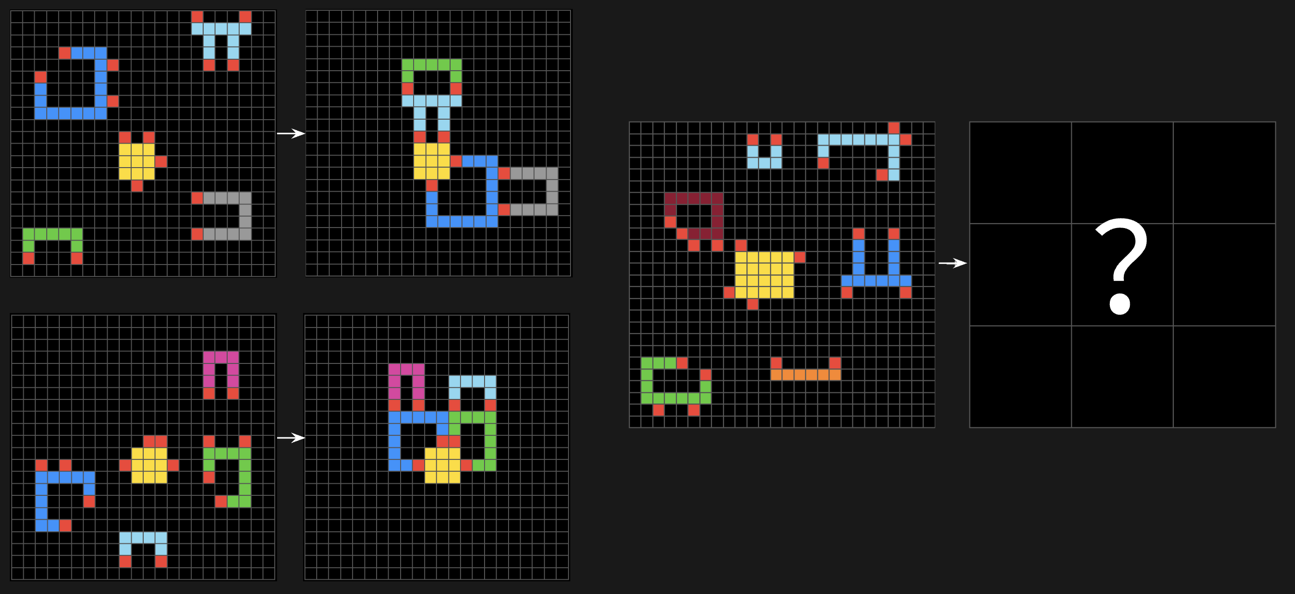

Symbolic Interpretation (符号解释)

我们发现,前沿 AI 推理系统在需要将符号解释为具有超出其视觉模式含义的任务中挣扎。系统尝试了对称性检查、镜像、转换,甚至识别出连接元素,但未能为符号本身赋予语义意义。

符号解释示例,ARC-AGI-2 Pubic Eval Task #e3721c99. Try this task.

符号解释示例,ARC-AGI-2 Pubic Eval Task #e3721c99. Try this task.

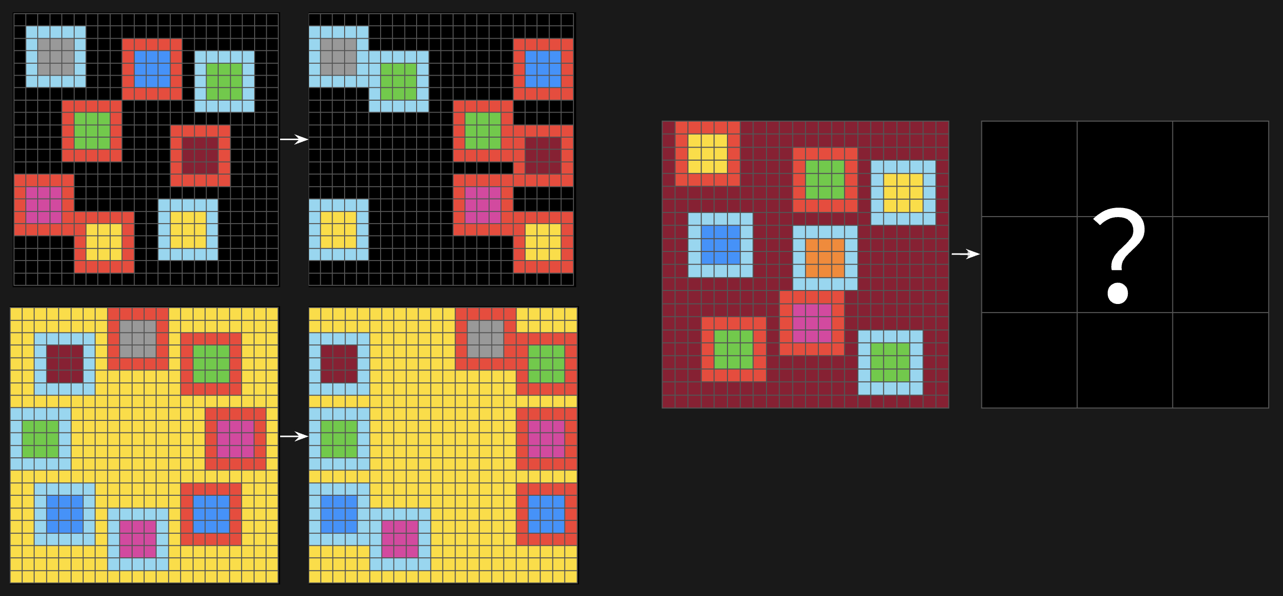

Compositional Reasoning (组合推理)

我们发现 AI 推理系统在需要同时应用规则或应用彼此交互的多个规则的任务中挣扎。相比之下,如果一个任务只有一个或非常少的全局规则,我们发现这些系统可以始终如一地发现和应用它们。

组合推理示例,ARC-AGI-2 Pubic Eval Task #cbebaa4b. Try this task.

组合推理示例,ARC-AGI-2 Pubic Eval Task #cbebaa4b. Try this task.

Contextual Rule Application (上下文规则应用)

我们发现 AI 推理系统在必须根据上下文以不同方式应用规则的任务中挣扎。系统倾向于专注于肤浅的模式,而不是理解底层的选择原则。

上下文规则应用示例,ARC-AGI-2 Pubic Eval Task #b5ca7ac4. Try this task.

上下文规则应用示例,ARC-AGI-2 Pubic Eval Task #b5ca7ac4. Try this task.

Datasets (数据集)

ARC-AGI-2 由以下数据集组成:

Dataset | Task Quantity | Calibration | Visibilty | Description ---|---|---|---|--- Training | 1000 | Uncalibrated | Public | 对人类和 AI 而言,难度各异,从非常容易到非常困难,旨在揭示和教授核心知识先验;用于训练您的系统。 Public Eval | 120 | Calibrated | Public | 所有任务都由至少两名人类以 pass@2 解决;用于测试您的系统。 Semi-Private Eval | 120 | Calibrated | Private | 所有任务都由至少两名人类以 pass@2 解决,用于 Kaggle 实时竞赛排行榜和 ARC Prize 排行榜。“Semi”意味着这些任务可能已通过 API 暴露给有限的第三方。 Private Eval | 120 | Calibrated | Private | 所有任务都由至少两名人类以 pass@2 解决,用于 Kaggle 最终竞赛排行榜。“Private”意味着这些任务尚未暴露给第三方。

Calibrated 表示这些任务是 IDD(独立且同分布的)。原则上,公共、半私有和私有评估集中的非过拟合分数应该是直接可比的。为了收集这些数据,我们对超过 400 名人类进行了现场受控测试。公共任务的人类可解性数据将在未来几周内与 ARC-AGI-2 论文一起开源。

与 ARC-AGI-1 一样,ARC-AGI-2 使用 pass@2 测量系统来解释某些任务具有显式歧义并需要两次猜测才能消除歧义的事实。以及捕获数据集中的任何无意歧义或错误。鉴于对 ARC-AGI-2 的受控人类测试,我们比 ARC-AGI-1 更自信于任务质量。

这是 ARC-AGI-2 的官方 changelog:

- 所有评估集(公共、半私有、私有)现在包含 120 个任务(从 100 个增加)。

- 从评估集中删除了容易受到暴力搜索攻击的任务(原始 2020 Kaggle contest 中的所有已解决任务)。

- 执行受控人类测试以校准评估集难度,以确保 IDD 并验证至少 2 个人通过 pass@2 可解性(以匹配 AI 规则)。

- 根据研究(符号解释、组合推理、上下文规则等)设计了新的任务来挑战 AI 推理系统。

我们还针对所有公共 AI 系统重新评估了 ARC-AGI-2。以下是起始分数。

System | ARC-AGI-1 | ARC-AGI-2 | Efficiency (cost/task) ---|---|---|--- Human panel (at least 2 humans) | 98% | 100% | $17 Human panel (average) | 64.2% | 60% | $17 o3-low (CoT + Search/Synthesis) | 75.7% | 4%* | $200 o1-pro (CoT + Search/Synthesis) | ~50% | 1%* | $200* ARChitects (Kaggle 2024 Winner) | 53.5% | 3% | $0.25 o3-mini-high (Single CoT) | 35% | 0.0% | $0.41 r1 and r1-zero (Single CoT) | 15.8% | 0.3% | $0.08 gpt-4.5 (Pure LLM) | 10.3% | 0.0% | $0.29

标有 * 的分数是基于我们迄今为止能够汇总的部分结果和 o1-pro 定价的正在进行的估计。完整结果将在可用后发布。

所有报告的分数均为 pass@2 并且在半私有评估集上(ARC-AGI-1 人类小组和 ARChitects 除外,分别使用公共和私有评估)。

人类小组效率基于 $115-150 的出场费,加上 $5/任务的解决激励。我们优化了成本以产生出场次数(只有 70% 的注册实际上出现了)。即使我们相信人类智力成本效率的真正限制可能在 $2-5/任务范围内,但我们报告 $17/任务以反映我们收集的实际数据。

我们期待在 API 访问可用后测试 OpenAI o3 low/high 的生产版本。使用转移到 ARC-AGI-2 的 ARC-AGI-1 任务,我们估计 o3-low 将获得约 4% 的分数,而 o3-high 可能获得高达 15-20% 的分数,但需要非常高的计算成本(每个任务数千美元)。

智能不仅仅是能力

展望未来,所有 ARC-AGI 报告都将附带效率指标。我们从成本开始,因为它是人类和 AI 性能之间最直接可比的。

智能不仅仅由解决问题或获得高分的能力来定义。获得和部署这些能力的效率是一个至关重要的定义组成部分。所问的核心问题不仅仅是“AI 能否获得解决任务的技能?”,还有“以什么效率或成本?”

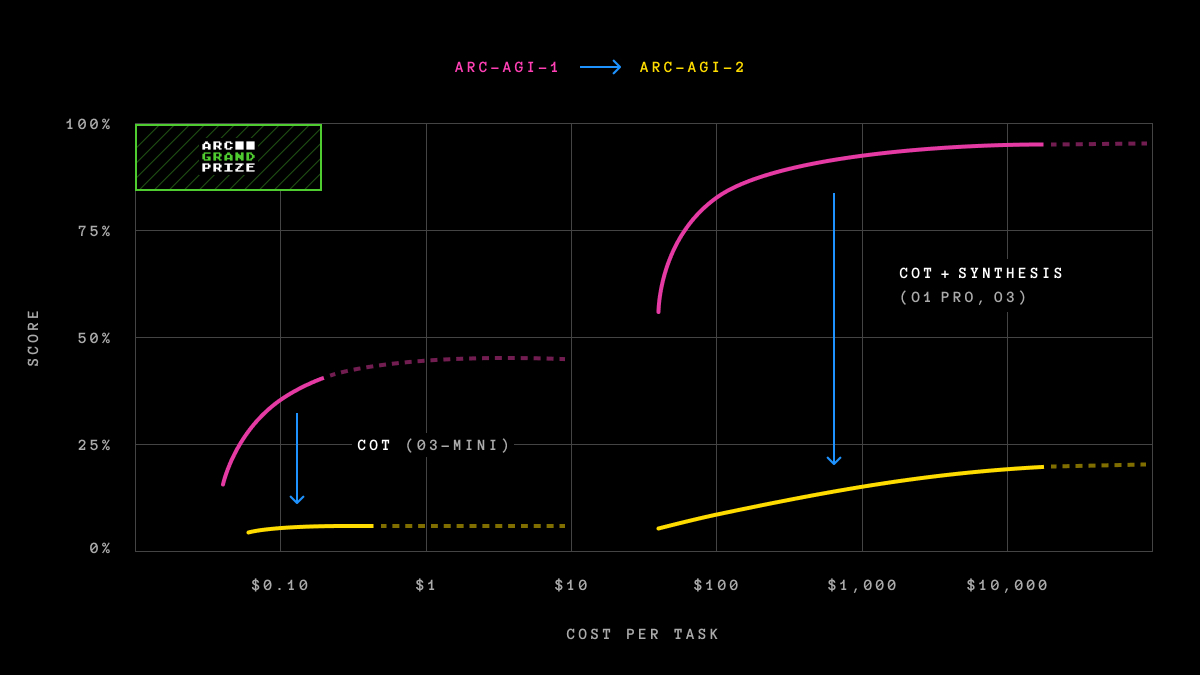

前沿 AI 系统在 ARC-AGI-1 与 ARC-AGI-2 上的得分

前沿 AI 系统在 ARC-AGI-1 与 ARC-AGI-2 上的得分

我们知道暴力搜索最终可以解决 ARC-AGI(如果提供无限的资源和搜索时间)。这并不代表真正的智能。智能在于高效地找到解决方案,而不是详尽地寻找。

这种对效率的关注是 ARC-AGI 背后的核心原则。我们现在将明确量化智能的成本,要求解决方案不仅展示能力,还要展示定义通用智能的资源的高效利用。

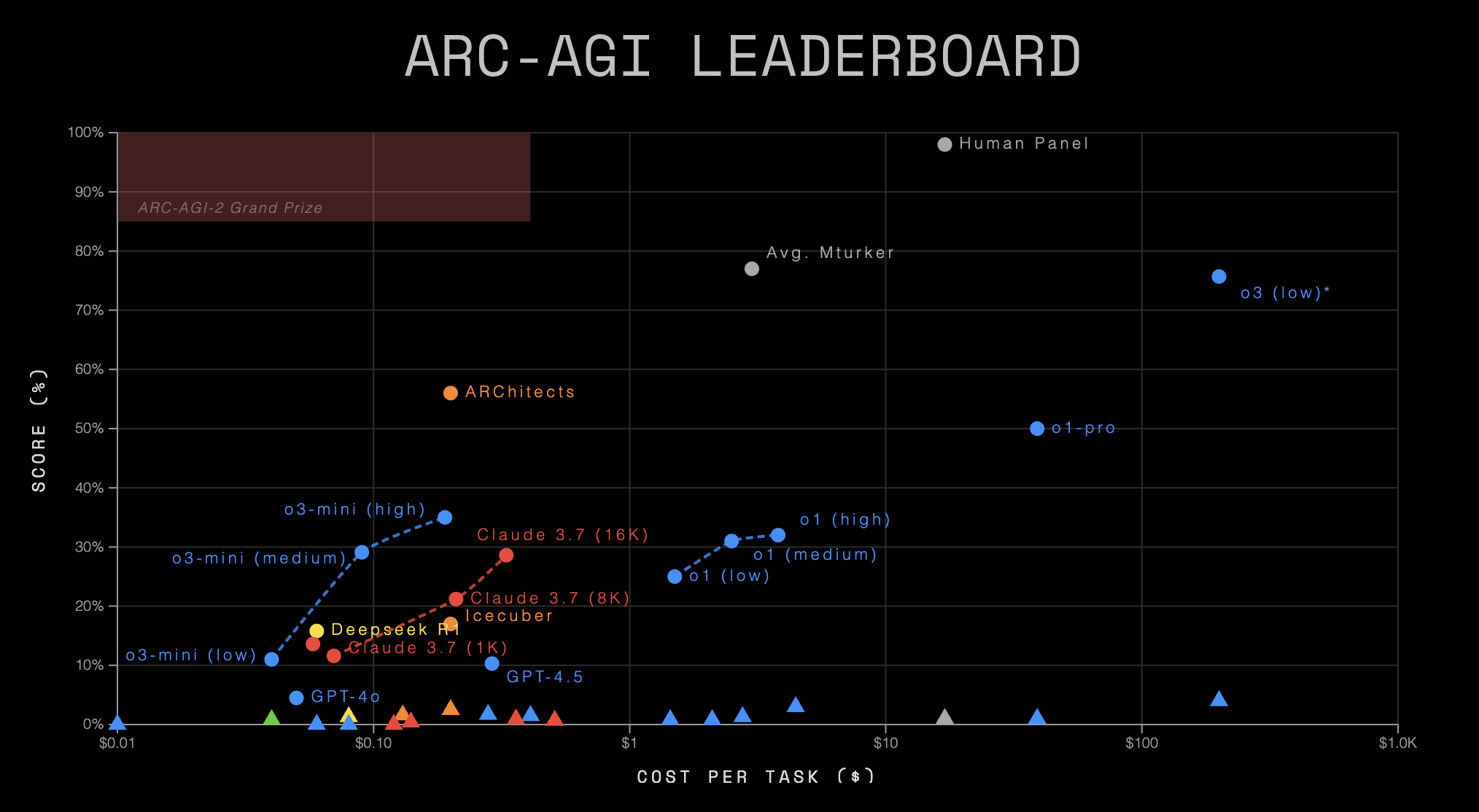

我们的新排行榜页面报告了沿分数和成本轴的进展。

ARC-AGI 的新排行榜,显示了截至 2025 年 3 月 24 日的分数和效率

ARC-AGI 的新排行榜,显示了截至 2025 年 3 月 24 日的分数和效率

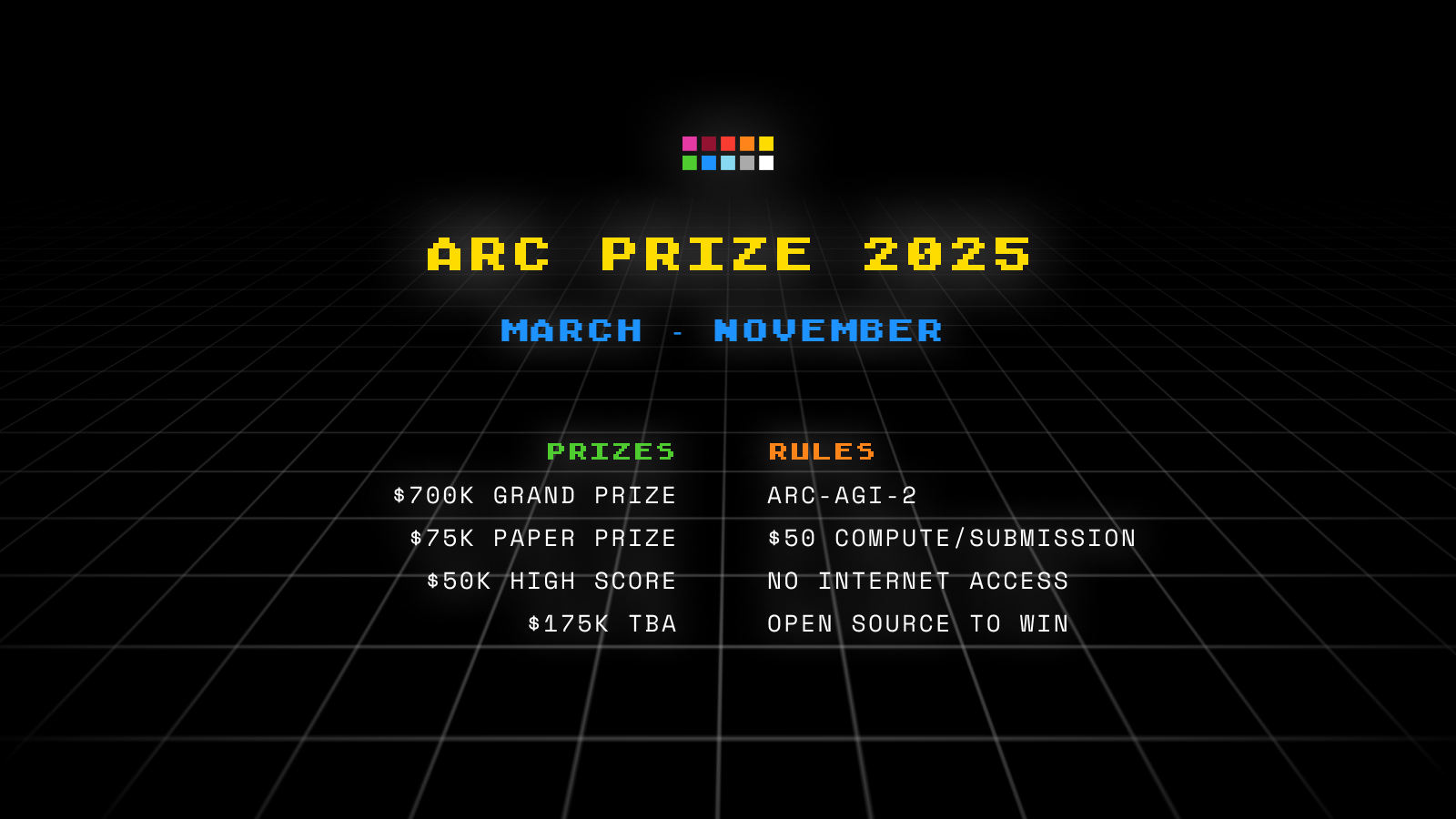

竞赛本周上线! 1,000,000 美元奖金

与 ARC-AGI-2 一起,我们很高兴地宣布 ARC Prize 2025 is back!竞赛将再次在 Kaggle 上举办,时间为 3 月至 11 月。竞赛将于本周晚些时候上线,在此处注册以获取通知。

有 12.5 万美元的保证进度奖金,以及额外的 70 万美元大奖(比去年增加了 10 万美元!),等待通过得分高于 85% 的解决方案解锁,以及 17.5 万美元的待宣布奖金。

与 arcprize.org 上的公共排行榜不同,Kaggle 规则限制您使用互联网 API,并且每次提交只能获得约 50 美元的计算资源。为了有资格获得奖金,参赛者必须在比赛结束时开源并将其解决方案和工作成果分享到公共领域。

去年的比赛取得了令人难以置信的成功——超过 1,500 支队伍参加,产生了 40 篇有影响力的研究论文。获得 ARC Prize 的研究人员引入了现在在 AI 行业中采用的创新。

今年你能解锁并与世界分享什么进展?

奖金类别

Grand Prize ($700K) (大奖(70 万美元))一旦第一支队伍在 Kaggles 效率限制内达到 85% 即可解锁。

Top Score Prize ($75K) (最高分奖(7.5 万美元))颁发给得分最高的提交。

Paper Prize ($50K) (论文奖(5 万美元))颁发给展示出解决 ARC-AGI 的最重要概念进展的提交。论文必须与评分提交相关联,但创新思想比获得高分更重要。

To-be-announced Prizes ($175k) (待公布奖金(17.5 万美元))有关这些奖金的更多细节将在 2025 年比赛期间公布。

您可以在我们的Competition page上找到更多详细信息。

Changelog (更新日志)

以下是从 2024 年到 2025 年的比赛 changelog 的快速浏览。

- ARC-AGI-2: 我们将从现在开始替换 ARC-AGI-1 数据集。

- New leaderboard reporting: Kaggle 实时比赛排行榜将报告半私有的分数,最终奖金结果将在内容关闭后一次性在私有评估上报告。

- Stronger open-source provisions: 团队将需要在收到官方私有评估集分数之前开源其解决方案。

- More compute: 2x compute vs. 2024 (L4x4s),现在约为 50 美元。

- More overfit prevention: 我们对 Kaggle 上的分数报告进行了其他更改,以减少数据挖掘和过度拟合,并激励概念性进展。

进步取决于新想法——也许是你的?

AI 的当前状态在一个受想法约束的环境中运行。下一个突破可能不是来自主要的 AI 实验室,而是来自像您这样的人的一种新的、创造性的方法。

如果您对好奇心充满动力,受到复杂性的启发,并致力于对真正的通用智能进行严格的追求,那么 ARC Prize 2025 就是您的机会。

加入我们,追求开放科学。

准备好开始了?

祝你好运!我们迫不及待地想看看你建造了什么。 Join the 2025 Competition

© 2025 ARC Prize, Inc. Privacy Terms Donate A non-profit for the public advancement of open artificial general intelligence. All rights reserved.

ARC Prize 2025: Get Started

The Kaggle competition is going live this week! Sign up to enter and get notified. Sign Up No spam. You can unsubscribe at anytime.

ARC Prize : Newsletter

Subscribe to get started and receive official contest updates and news. Subscribe No spam. You can unsubscribe at anytime. Toggle Animation