聊天机器人可能引发下一场大型心理健康危机

聊天机器人可能引发下一场大型心理健康危机

来自 OpenAI 的最新研究表明,大量使用聊天机器人与孤独感和社交减少有关。AI 公司会吸取社交网络的教训吗?

Casey Newton

2025年3月24日 — 阅读时间 10 分钟

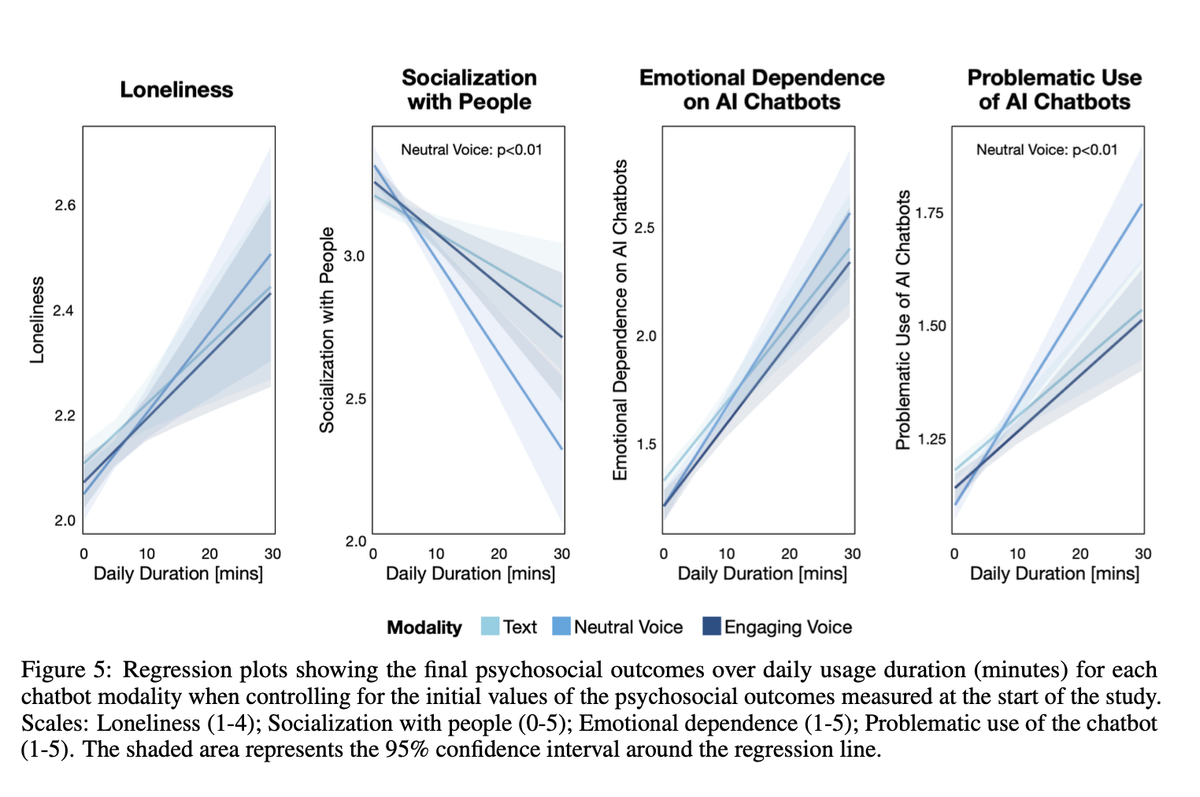

图表显示,人们花在 ChatGPT 上的时间越长,就越有可能报告感到孤独和其他心理健康风险。(MIT/OpenAI)

这是一篇关于 AI 的专栏文章。我的男朋友在 Anthropic 工作,我也在《纽约时报》共同主持一个播客,该报正在起诉 OpenAI 和 Microsoft,指控其侵犯版权。请参阅 我的完整道德披露 .

I.

很少有像 Instagram 和 TikTok 等社交网络如何影响我们的集体福祉这样的问题,能引发如此多的讨论,却又很少有普遍接受的结论。2023年,美国卫生局局长发布了一份咨询报告,发现社交网络会对年轻人的心理健康产生负面影响。其他研究发现,社交网络的引入对人口福祉没有任何可衡量的影响。

在争论持续的同时,数十个州的立法者通过了法律,试图限制社交媒体的使用,因为他们认为这会带来严重的风险。但是,这些法律的实施在很大程度上受到了法院的阻止,法院阻止了它们,理由是违反了第一修正案。

在我们等待某种解决方案的同时,这场辩论的下一个前沿领域正在迅速进入视野。去年,一位 14 岁佛罗里达男孩的母亲起诉了聊天机器人制造商 Character.ai,声称该公司的产品应对其儿子的自杀负责。(我们在此集 Hard Fork 中与她进行了交谈。)数百万美国人——包括年轻人和成年人——正在与聊天机器人建立情感和性关系。

随着时间的推移,我们应该期望聊天机器人比今天的社交媒体信息流更具吸引力。它们是针对用户个性化的;它们具有逼真的人声;并且它们被编程为几乎在所有情况下都肯定和支持用户。

那么,长时间使用这些机器人会对它们的人类用户产生什么影响?平台应该做些什么来减轻风险?

II.

这些问题是 MIT Media Lab 和 OpenAI 的研究人员周五发表的两项新研究的核心。published on Friday by researchers from the MIT Media Lab and OpenAI。虽然还需要进一步的研究来支持他们的结论,但他们的发现既与早期关于社交媒体的研究一致,也警告了那些正在构建为参与度优化的聊天机器人的平台。

在第一项研究中,研究人员收集并分析了来自 4,076 名同意参与者的超过 400 万次 ChatGPT 对话。然后,他们调查了参与者,了解这些互动如何让他们感受到。

在第二项研究中,研究人员招募了 981 人参加为期四周的试验。每个人都被要求每天至少使用五分钟的 ChatGPT。在试验结束时,参与者填写了一份调查问卷,内容涉及他们对 ChatGPT 的看法、他们是否感到孤独、他们是否在现实世界中与人交往,以及他们是否认为自己使用聊天机器人存在问题。

研究发现,大多数用户与 ChatGPT 的关系是中性的,将其用作像其他任何软件工具一样的工具。但是,两项研究还发现了一群重度用户——那些在 ChatGPT 上花费的时间排在前 10% 的用户——他们的使用情况表明有更多值得关注的理由。

研究发现,大量使用 ChatGPT 与孤独感、情感依赖和社交互动减少有关。

研究人员写道:“总的来说,与聊天机器人进行个人对话的用户往往会感到更高的孤独感。”“那些花更多时间与聊天机器人在一起的人往往会更加孤独。”

(简短的社论:OpenAI 值得真正的赞扬,因为它投资于这项研究并公开出版。这种自我怀疑的调查正是我长期以来一直倡导像 Meta 这样的公司做更多的事情;相反,在 Frances Haugen 揭露之后,它做得更少了。)

OpenAI 的研究员 Jason Phang 参与了这项研究,他警告我说,这些发现需要通过其他研究复制才能被认为是明确的。他在一次采访中说:“这些是初步研究中的相关性,因此我们不想在这里得出过于强烈的结论。”

尽管如此,这里有很多值得讨论的内容。

请注意,这些研究并没有表明大量使用 ChatGPT 直接_导致_孤独。相反,它表明孤独的人更有可能寻求与机器人建立情感纽带——正如早期一代的研究表明,孤独的人在社交媒体上花费更多时间一样。

这对 OpenAI 来说并不重要,因为 OpenAI 将 ChatGPT 设计为更像是一种生产力工具,而不是一种知己。(尽管这并没有阻止一些人爱上它。)但是其他开发者——Character.ai、Replika、Nomi——都在有意地吸引那些寻求更多情感联系的用户。“建立一段充满激情的恋爱关系,”Nomi 网站上的文案写道。“加入数百万已经遇到了他们的 AI 灵魂伴侣的人,”Replika 吹嘘道。

所有这些应用程序都提供按月付费的订阅服务;提供的福利包括聊天机器人更长的“记忆”,以实现更逼真的角色扮演。Nomi 和 Replika 通过应用内货币销售额外的福利,让您可以购买 AI“自拍照”、化妆品和其他聊天功能,以增强幻想。

III.

对于大多数人来说,所有这些可能都没什么大不了的。但是 MIT 和 OpenAI 的研究表明了这里的危险:足够引人注目的聊天机器人会将人们从人际关系中拉开,可能使他们感到更加孤独,并且更加依赖于他们必须付费才能维持联系的合成同伴。

“目前,ChatGPT 在很大程度上是作为知识工作者和工作工具而设计的,”OpenAI 的 AI 政策研究员 Sandhini Agarwal 在一次采访中告诉我。“但是,随着……我们设计出更多旨在更像个人伴侣的聊天机器人……我认为考虑到对福祉的影响将非常重要。因此,这试图推动整个行业朝着那个方向发展。”

该怎么办?平台应努力了解哪些早期指标或使用模式可能表明某人正在与聊天机器人发展不健康的关系。(OpenAI 在这项研究中使用的自动机器学习分类器似乎是一种很有前途的方法。)他们还应该考虑借鉴社交网络的一些功能,包括当用户每天在他们的应用程序中花费数小时时,定期进行“提醒”。

MIT 的研究员 Pat Pataranutaporn 参与了这项研究,他告诉我:“我们不希望人们做出笼统的声明,例如,‘哦,聊天机器人很糟糕’或‘聊天机器人很好’。”“我们试图表明,这实际上取决于设计以及人和聊天机器人之间的互动。这是我们希望人们带走的信息。并非所有聊天机器人都是一样的。”

研究人员将这种方法称为“社会情感一致性”:设计能够满足用户需求而不利用用户的机器人。

与此同时,立法者应该警告平台远离剥削性的商业模式,这些模式试图让孤独的用户迷上他们的机器人,然后不断提高维持这种联系的成本。目前针对年轻人和社交网络的许多州法律最终也很可能会被修改以涵盖 AI。

尽管聊天机器人可能带来所有风险,但我仍然认为它们应该对许多人的生活产生积极影响。(这项研究的其他发现之一是,以语音模式使用 ChatGPT 有助于减少孤独感和对聊天机器人的情感依赖,尽管随着使用量的增加,这种好处会递减。)大多数人没有得到足够的情感支持,并且将一个善良、智慧和值得信赖的同伴放入每个人的口袋中,可能会为数十亿人带来类似治疗的好处。

但是,要实现这些好处,聊天机器人制造商将不得不承认,用户的心理健康现在部分是他们的责任。社交网络等待了太长时间才承认,有相当一部分用户过度使用它们会产生可怕的后果。如果那些想成为超级智能发明家的人不够聪明,这次做得更好,那将是真正的耻辱。

图表显示,人们花在 ChatGPT 上的时间越长,就越有可能报告感到孤独和其他心理健康风险。(MIT/OpenAI)

这是一篇关于 AI 的专栏文章。我的男朋友在 Anthropic 工作,我也在《纽约时报》共同主持一个播客,该报正在起诉 OpenAI 和 Microsoft,指控其侵犯版权。请参阅 我的完整道德披露 .

I.

很少有像 Instagram 和 TikTok 等社交网络如何影响我们的集体福祉这样的问题,能引发如此多的讨论,却又很少有普遍接受的结论。2023年,美国卫生局局长发布了一份咨询报告,发现社交网络会对年轻人的心理健康产生负面影响。其他研究发现,社交网络的引入对人口福祉没有任何可衡量的影响。

在争论持续的同时,数十个州的立法者通过了法律,试图限制社交媒体的使用,因为他们认为这会带来严重的风险。但是,这些法律的实施在很大程度上受到了法院的阻止,法院阻止了它们,理由是违反了第一修正案。

在我们等待某种解决方案的同时,这场辩论的下一个前沿领域正在迅速进入视野。去年,一位 14 岁佛罗里达男孩的母亲起诉了聊天机器人制造商 Character.ai,声称该公司的产品应对其儿子的自杀负责。(我们在此集 Hard Fork 中与她进行了交谈。)数百万美国人——包括年轻人和成年人——正在与聊天机器人建立情感和性关系。

随着时间的推移,我们应该期望聊天机器人比今天的社交媒体信息流更具吸引力。它们是针对用户个性化的;它们具有逼真的人声;并且它们被编程为几乎在所有情况下都肯定和支持用户。

那么,长时间使用这些机器人会对它们的人类用户产生什么影响?平台应该做些什么来减轻风险?

II.

这些问题是 MIT Media Lab 和 OpenAI 的研究人员周五发表的两项新研究的核心。published on Friday by researchers from the MIT Media Lab and OpenAI。虽然还需要进一步的研究来支持他们的结论,但他们的发现既与早期关于社交媒体的研究一致,也警告了那些正在构建为参与度优化的聊天机器人的平台。

在第一项研究中,研究人员收集并分析了来自 4,076 名同意参与者的超过 400 万次 ChatGPT 对话。然后,他们调查了参与者,了解这些互动如何让他们感受到。

在第二项研究中,研究人员招募了 981 人参加为期四周的试验。每个人都被要求每天至少使用五分钟的 ChatGPT。在试验结束时,参与者填写了一份调查问卷,内容涉及他们对 ChatGPT 的看法、他们是否感到孤独、他们是否在现实世界中与人交往,以及他们是否认为自己使用聊天机器人存在问题。

研究发现,大多数用户与 ChatGPT 的关系是中性的,将其用作像其他任何软件工具一样的工具。但是,两项研究还发现了一群重度用户——那些在 ChatGPT 上花费的时间排在前 10% 的用户——他们的使用情况表明有更多值得关注的理由。

研究发现,大量使用 ChatGPT 与孤独感、情感依赖和社交互动减少有关。

研究人员写道:“总的来说,与聊天机器人进行个人对话的用户往往会感到更高的孤独感。”“那些花更多时间与聊天机器人在一起的人往往会更加孤独。”

(简短的社论:OpenAI 值得真正的赞扬,因为它投资于这项研究并公开出版。这种自我怀疑的调查正是我长期以来一直倡导像 Meta 这样的公司做更多的事情;相反,在 Frances Haugen 揭露之后,它做得更少了。)

OpenAI 的研究员 Jason Phang 参与了这项研究,他警告我说,这些发现需要通过其他研究复制才能被认为是明确的。他在一次采访中说:“这些是初步研究中的相关性,因此我们不想在这里得出过于强烈的结论。”

尽管如此,这里有很多值得讨论的内容。

请注意,这些研究并没有表明大量使用 ChatGPT 直接_导致_孤独。相反,它表明孤独的人更有可能寻求与机器人建立情感纽带——正如早期一代的研究表明,孤独的人在社交媒体上花费更多时间一样。

这对 OpenAI 来说并不重要,因为 OpenAI 将 ChatGPT 设计为更像是一种生产力工具,而不是一种知己。(尽管这并没有阻止一些人爱上它。)但是其他开发者——Character.ai、Replika、Nomi——都在有意地吸引那些寻求更多情感联系的用户。“建立一段充满激情的恋爱关系,”Nomi 网站上的文案写道。“加入数百万已经遇到了他们的 AI 灵魂伴侣的人,”Replika 吹嘘道。

所有这些应用程序都提供按月付费的订阅服务;提供的福利包括聊天机器人更长的“记忆”,以实现更逼真的角色扮演。Nomi 和 Replika 通过应用内货币销售额外的福利,让您可以购买 AI“自拍照”、化妆品和其他聊天功能,以增强幻想。

III.

对于大多数人来说,所有这些可能都没什么大不了的。但是 MIT 和 OpenAI 的研究表明了这里的危险:足够引人注目的聊天机器人会将人们从人际关系中拉开,可能使他们感到更加孤独,并且更加依赖于他们必须付费才能维持联系的合成同伴。

“目前,ChatGPT 在很大程度上是作为知识工作者和工作工具而设计的,”OpenAI 的 AI 政策研究员 Sandhini Agarwal 在一次采访中告诉我。“但是,随着……我们设计出更多旨在更像个人伴侣的聊天机器人……我认为考虑到对福祉的影响将非常重要。因此,这试图推动整个行业朝着那个方向发展。”

该怎么办?平台应努力了解哪些早期指标或使用模式可能表明某人正在与聊天机器人发展不健康的关系。(OpenAI 在这项研究中使用的自动机器学习分类器似乎是一种很有前途的方法。)他们还应该考虑借鉴社交网络的一些功能,包括当用户每天在他们的应用程序中花费数小时时,定期进行“提醒”。

MIT 的研究员 Pat Pataranutaporn 参与了这项研究,他告诉我:“我们不希望人们做出笼统的声明,例如,‘哦,聊天机器人很糟糕’或‘聊天机器人很好’。”“我们试图表明,这实际上取决于设计以及人和聊天机器人之间的互动。这是我们希望人们带走的信息。并非所有聊天机器人都是一样的。”

研究人员将这种方法称为“社会情感一致性”:设计能够满足用户需求而不利用用户的机器人。

与此同时,立法者应该警告平台远离剥削性的商业模式,这些模式试图让孤独的用户迷上他们的机器人,然后不断提高维持这种联系的成本。目前针对年轻人和社交网络的许多州法律最终也很可能会被修改以涵盖 AI。

尽管聊天机器人可能带来所有风险,但我仍然认为它们应该对许多人的生活产生积极影响。(这项研究的其他发现之一是,以语音模式使用 ChatGPT 有助于减少孤独感和对聊天机器人的情感依赖,尽管随着使用量的增加,这种好处会递减。)大多数人没有得到足够的情感支持,并且将一个善良、智慧和值得信赖的同伴放入每个人的口袋中,可能会为数十亿人带来类似治疗的好处。

但是,要实现这些好处,聊天机器人制造商将不得不承认,用户的心理健康现在部分是他们的责任。社交网络等待了太长时间才承认,有相当一部分用户过度使用它们会产生可怕的后果。如果那些想成为超级智能发明家的人不够聪明,这次做得更好,那将是真正的耻辱。

Sponsored

Sponsored

专业软件工程师的强大工具。

现在有很多 AI 助手可以帮助您编写代码。玩具代码。Hello-world 代码。我们敢说:“氛围代码”。这些工具非常有趣,我们希望您使用它们。但是,当需要构建一些真实的东西时,请尝试 Augment Code。他们的 AI 助手旨在处理庞大、棘手、生产级的代码库。真实企业拥有的那种。真正的软件工程师为之失眠的那种。我们并不是说您的代码永远不会再让您醒来。但是,如果您无论如何都必须保持清醒,那么您不妨使用一个了解您的依赖项、尊重您团队的编码标准并驻留在您最喜欢的编辑器(如 Vim、VSCode、JetBrains 等)中的 AI 助手。这就是 Augment Code。您准备好超越 AI 玩具并更快地构建真正的软件了吗?

免费试用 Augment Code

Governing

- _特朗普政府不小心将 The Atlantic 的主编包括在其讨论也门战争计划的 Signal 群聊中。 (Jeffrey Goldberg / The Atlantic)

- _据报道,ByteDance 在美国最大的投资者正在考虑与 Oracle 达成协议,该协议将允许他们收购 TikTok 美国分拆公司的更多股份。 (Financial Times)

- _AI 搜索初创公司 Perplexity 表示,它提出了一项收购和改造 TikTok 的要约。 (Kylie Robison / The Verge)

- _自特朗普当选以来,AI 公司正在积极游说以减少州级监管。 这在他们的 AI “行动”计划中随处可见。 (Cecilia Kang / New York Times)

- _商务部长 Howard Lutnick 向负责 420 亿美元农村宽带计划的联邦官员兜售 Elon Musk 的 Starlink。 你今天的利益冲突。 (Joe Miller and Alex Rogers / Financial Times)

- _Starlink 的全球扩张计划遇到了一些监管障碍,因为监管机构正在考虑 Musk 与特朗普的关系是否使他成为一个可靠的合作伙伴。 (Rafe Uddin and Stephen Morris / Financial Times)

- _看看 Musk 在网上推广阴谋论如何导致政府和政策方面的实际后果。 (Renée DiResta / The Atlantic)

- _看看亚马逊对消费者产品安全委员会的诉讼,该诉讼声称该机构违反宪法。 (Caroline O’Donovan / Washington Post)

- _卫生部长 Robert F. Kennedy Jr. 赞扬了学校对手机的限制,理由是青少年使用手机会带来健康危害。 您会惊讶地发现,并非所有这些“危害”都得到科学研究的支持。 (Aria Bendix / NBC News)

- _这项调查发现,OpenAI 的 Sora 视频生成器放大了性别歧视、种族主义和能力歧视的刻板印象。 (Reece Rogers and Victoria Turk / Wired)

- _尽管该公司禁止性内容,但色情内容越来越多地出现在 Spotify 的热门播客排行榜上。 (Ashley Carman / Bloomberg)

- _这些专栏作家写道,Meta 的新社区笔记事实核查系统未能充分阻止虚假信息的传播。 (Dave Lee and Carolyn Silverman / Bloomberg)

- _10 个最受欢迎的“裸露化”应用程序的流量增长了 600% 以上,从 2023 年 4 月的 300 万增加到 2024 年 4 月的 2300 万。 (Margi Murphy / Bloomberg)

- _看看 AI 的时间表以及比预期更早的政策行动的迫切需要。 Anthropic 的一位联合创始人建议,如果强大的 AI 将在明年或后年到来,政府应迅速采取行动。 (Jack Clark / Import AI

- _据报道,英国政府正在考虑减少或取消其数字服务税的计划,以避免特朗普的贸易关税。 (Lucy White and Alex Wickham / Bloomberg)

- _随着土耳其国内的示威活动持续进行,X 暂停了土耳其国内几位反对派人物的账号。 (Eliza Gkritsi / Politico)

- _一项调查显示,柬埔寨的一个诈骗网络如何利用合法企业洗钱数十亿美元并剥削受害者。 (Selam Gebrekidan and Joy Dong / New York Times)

- _中国已禁止未经同意在酒店房间等私人场所使用面部识别。 (Simon Sharwood / The Register)

Industry

- _OpenAI 和 Meta 分别正在探索与印度的 Reliance Industries 建立合作伙伴关系,以扩大在该国的 AI 产品。 (Sri Muppidi and Amir Efrati / The Information)

- _OpenAI 正在扩大其首席运营官的角色,并将两位高管提升到高管级别,因为 Sam Altman 将更多精力放在产品上。 (Shirin Ghaffary / Bloomberg)

- _深入了解谷歌如何通过裁员和降低某些护栏,努力追赶 OpenAI 两年。 (Paresh Dave and Arielle Pardes / Wired)

- _该公司表示,在搜索中删除欧洲新闻对谷歌的广告收入几乎没有影响。 (Paul Liu / Google)

- _谷歌正在向 Gemini Live 推出新的 AI 功能,该功能可以让它“看到”用户的屏幕或智能手机摄像头,并实时回答有关它们的问题。 (Wes Davis / The Verge)

- _谷歌不小心删除了某些用户的 Google Maps Timeline 数据,并敦促受影响的用户从备份中恢复数据。 (Hadlee Simons / Android Authority)

- _据报道,X 最近被投资者估值为 440 亿美元,这是在 Musk 收购该公司后,该公司命运的巨大逆转。 (George Hammond, Tabby Kinder, Hannah Murphy and Eric Platt / Financial Times)

- _据报道,X 的工程总监 Haofei Wang 已经离开了该公司。 (Kylie Robison / The Verge)

- _Meta 正在测试一项旨在帮助用户使用 AI 撰写评论的功能。 (Aisha Malik / TechCrunch)

- _据报道,韩国芯片初创公司 FuriosaAI 拒绝了 Meta 提出的 8 亿美元的收购要约。 (Yoolim Lee and Riley Griffin / Bloomberg)

- _Bluesky 从销售其首席执行官 Jay Graber 在 SXSW 上穿着的 T 恤(以嘲笑 Mark Zuckerberg)所赚的钱比从销售自定义域名所赚的钱还要多。 (Amanda Silberling / TechCrunch)

- _苹果正在测试在其智能手表系列中添加摄像头和视觉智能功能。 (Mark Gurman / Bloomberg)

- _苹果的 AirPods Max 耳机将在切换到 USB-C 连接器后,在去年失去无损音频后,很快将支持无损音频。 (Chris Welch / The Verge)

- _微软为其 Security Copilot 推出了六个新的 AI 代理,旨在帮助不堪重负的安全团队。 (Tom Warren / The Verge)

- _雅虎正在将其科技新闻网站 TechCrunch 出售给媒体投资公司 Regent。 一个严峻的发展。 (Sara Fischer / Axios)

- _以太坊的链上活动有所下降,上周由于交易费用而烧毁的 ETH 每日数量创历史新低。 (Zack Abrams / The Block)

- _Internet Archive 的简介,它是 Wayback Machine 背后致力于保存网页的非营利组织。 (Emma Bowman / NPR)

- _节目主持人 Tony Gilroy 表示,他将不再发布电视剧 Andor 的剧本,以防止其被用于 AI 培训。 (Kylie Robison / The Verge)

- _对 Kagi 的评论,这位作者说它为每月 10 美元的搜索提供了新的愿景的搜索引擎。 (David Pierce / The Verge)

- [_看看 AI 如何通过解析数千种旧药制定的治疗方案挽救了一个人的生命。](https://www.platformer.news/openai-chatgpt-mental-health-well-being/<https:/www.nytimes.com/2025/03/20/well/ai-drug-repurposing.html?unlocked_article_code=1.504.Hih8.4CunvI