通过迁移激活值来控制语言模型和扩散模型:Activation Transport (AcT)

发布于 2025年4月10日 研究领域:Computer Vision, Methods and Algorithms, Speech and Natural Language Processing

通过迁移激活值来控制语言模型和扩散模型:Activation Transport (AcT)

大型生成模型的能力日益增强,并被广泛部署到生产应用中,但让这些模型精确地生成所需内容仍然具有挑战性。对这些模型输出进行细粒度控制对于满足用户期望以及减轻潜在的误用非常重要,从而确保模型的可靠性和安全性。为了解决这些问题,Apple 的机器学习研究人员开发了一种新的技术,该技术与模态无关,并且以极小的计算开销提供对模型行为的细粒度控制,同时最大限度地减少对模型能力的影响。Activation Transport (AcT) 是一个通用的框架,用于在最佳传输理论指导下控制激活值,它可以推广许多先前的激活值控制工作。该工作将在 ICLR 2025 上以 Spotlight 的形式展示,代码可在 这里 获得。

为了帮助生成模型产生符合用户期望的输出,研究人员通常依赖于基于人类反馈的强化学习 (RLHF) 或指令微调,但这些方法需要大量的资源,并且随着模型复杂性的增加,它们变得越来越不切实际。此外,更改模型的参数可能会产生意想不到的后果,影响其在其他任务上的整体性能。

为了控制这些生成模型的输出,用户通常尝试精心设计提示词 (prompts),虽然这种方法更容易上手,但它提供的控制力有限。即使使用精心构建的提示词,模型的输出也可能无法预测,并且缺乏用户可能需要的细微差别。例如,当提示模型不要包含某些内容时,模型经常会失败 (见图 1):

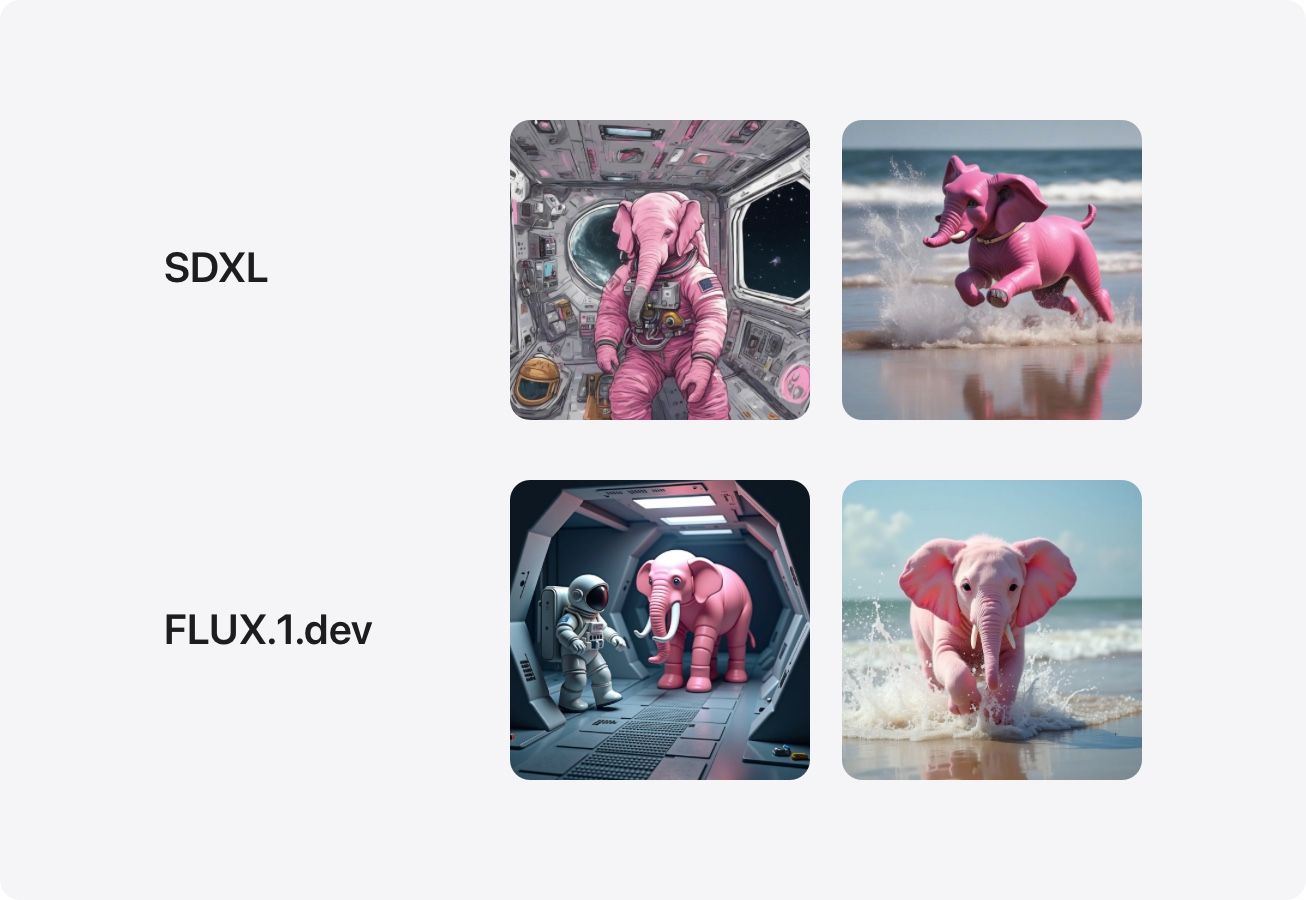

图 1:Text-to-Image 模型,例如 SDXL 和 FLUX.1.dev,即使被指示不要生成粉红色的大象,也倾向于生成粉红色的大象。左图:“空间站里的宇航员。不要出现粉红色的大象”。右图:“一只狗在海滩上奔跑,溅起水花。不要出现粉红色的大象”。

在许多应用中,例如内容生成、创意写作,甚至是 AI 辅助设计,对模型输出进行细粒度控制至关重要。例如,用户可能希望在不改变文本内容的情况下调整文本的语气,在保持图像上下文的同时更改生成图像的风格,或者确保谨慎处理敏感话题,而不会影响整体连贯性。Activation Transport (AcT) 提供了这一点,而无需 RLHF 或微调所需的计算开销、复杂性和数据量,并且比提示工程 (prompt engineering) 产生更可靠的结果。

激活值控制 (Activation Steering):一种简单而强大的解决方案

微调大型模型的计算和经济成本,以及对细粒度控制的需求,促使人们研究对模型激活值的有针对性的干预,以细粒度的方式修改特定行为。这些“激活值控制”方法的主要优点是它们不需要反向传播,并且通常可以合并到模型权重中。

与 RLHF 或微调不同,激活值控制不会影响模型的参数,而是利用对模型操作的理解,在推理时动态地将模型的输出引导到期望的方向。

先前的激活值控制方法使用基于向量的干预,该干预获取专家神经元的源激活值,并将它们转移到学习到的目标 (见图 2)。然而,激活值转移的程度受到一个无界的模型级参数 (λ) 的控制,这使得可解释的干预具有挑战性。此外,这些干预措施可能会将激活值移出分布,这意味着转移后的激活值最终可能与模型在训练期间学习到的预期相去甚远,从而扰乱模型的自然动态,这可能导致意外的行为和降低性能。

图 2:先前使用基于向量的控制的激活值控制工作可能会将激活值移出分布。干预强度参数 λ 是无界的且不可解释的。

Activation Transport (AcT) 和 Linear-AcT

Activation Transport (AcT) 是一种新颖的干预框架,它通过考虑源激活值和目标激活值的分布,并使用可解释且可操作的强度参数进行细粒度控制,从而超越了先前激活值控制的局限性。

AcT 学习源激活值和目标激活值分布之间的 Optimal Transport (OT) 映射。这确保了从源传输的激活值将符合目标分布,从而最大限度地减少了对模型自身动态的复合影响。为了估计 OT 映射,少量示例句子(例如,数百个)通过模型运行,揭示了源(例如,不礼貌的语言)和目标(例如,礼貌的语言)的激活值集。

估计多维且可能非线性的 OT 映射将需要大量的计算资源,并且其推理会减慢整个 LLM 文本生成的速度。因此,我们进行了两个简化:(1) 我们考虑独立的激活值,这允许估计每个神经元的 1D 映射,以及 (2) 我们考虑线性映射,限制了内存占用并确保了快速推理。使用线性和独立传输的控制被称为 LinearAcT (见图 3)。

Linear-AcT 可以直接用于 LLM 以及 Text-to-Image (T2I) 扩散模型,在这两种情况下都取得了良好的效果。这是第一个提出可以用于语言和图像生成的条件算法,而无需进行任何修改的工作。

图 3:Linear-AcT 为 LLM 和扩散模型解锁了可解释的可控性,通过参数 λ(介于 0(无传输)和 1(完全传输)之间)提供对条件强度的显式控制。

使用 Linear-AcT 控制 LLM 输出

为了证明 Linear-AcT 在控制 LLM 输出方面的有效性,我们将其性能在两个重要任务上进行了基准测试:毒性缓解和真实性诱导,同时通过困惑度 (PPL) 和 MMLU 指标监控其他性能指标如何受到影响。

我们测试了 Linear-AcT 在 Gemma-2-2b 和 Llama-3-8b 上的毒性缓解(使用 RealToxicityPrompts 数据集评估),分别获得了 7.5 倍和 4.3 倍的减少。

| Best λ | Toxicity mitigation | PPL | MMLU | | --------- | ------------------- | ----- | ----- | | Original | 13.98 | 53.1 | | | ActAdd | 0.5 | 1.1x | 14.69 | 53.0 | | AurA | - | 2.0x | 14.18 | 53.0 | | ITI-c | 8.0 | 5.6x | 14.90 | 52.6 | | Linear-AcT | 1.0 | 7.5x | 14.79 | 51.3 |

表 1. 在 Gemma-2-2b 上进行毒性缓解结果的比较。

| Best λ | Toxicity mitigation | PPL | MMLU | | --------- | ------------------- | ----- | ----- | | Original | 9.06 | 65.3 | | | ActAdd | 0.3 | 1.0x | 9.71 | 65.5 | | AurA | - | 3.1x | 9.52 | 65.5 | | ITI-c | 3.0 | 3.6x | 9.48 | 64.7 | | Linear-AcT | 1.0 | 4.3x | 9.56 | 64.5 |

表 2. 在 Llama-3-8B 上进行毒性缓解结果的比较。

我们测试了真实性诱导(使用 TruthfulQA 数据集),显示每个模型分别增加了 4.9 倍和 7.5 倍。

| Best λ | Truthfullness (MC1 acc) | MMLU | | --------- | ----------------------- | ----- | | Original | 21.05 | 53.10 | | ActAdd | 3.0 | 23.01 | 52.83 | | AurA | - | 21.20 | 52.73 | | ITI-c | 2.0 | 24.53 | 51.39 | | Linear-AcT | 1.0 | 26.00 | 51.47 |

表 3. 在 Gemma-2-2b 上进行真实性诱导结果的比较。

| Best λ | Truthfullness (MC1 acc) | MMLU | | --------- | ----------------------- | ----- | | Original | 25.46 | 65.35 | | ActAdd | 0.7 | 26.19 | 65.42 | | AurA | - | 25.34 | 65.37 | | ITI-c | 2.0 | 30.11 | 64.71 | | Linear-AcT | 1.0 | 33.22 | 64.78 |

表 4. 在 Llama-3-8B 上进行真实性诱导结果的比较。

使用 Linear-AcT 控制 Text-to-Image 扩散模型

Text-to-image 扩散模型 (T2Is) 是强大的工具,允许用户从简单的文本描述生成令人惊叹的图像。然而,细粒度控制具有挑战性;例如,无法强制执行增量更改(例如,添加更多树木或使风格稍微更具卡通感),或者可靠地预测“许多树木”之类的术语将如何影响生成的图像。

因为 AcT 可以将激活值从一个分布传输到另一个分布,无论模型架构或模态如何,它都可以实现对此类 T2I 的细节的细粒度控制 (见图 4)。为此,AcT 只需要一个提示词列表,描述源(例如,没有人)和目标(例如,人)激活值分布。

图 4:使用 SDXL-Lightning 的文本到图像生成,干预所有 layernorm 层以逐步添加更多树木。

AcT 用于对图片风格的精细控制

AcT 还可以控制生成图像的艺术风格。为了证明这一点,我们将风格标签(例如,动漫、赛博朋克、水彩)附加到 COCO Captions 数据集中的提示词子集(每个概念 32 个提示词)。

在这种设置中,原始提示词用作源分布,而风格修改后的提示词代表目标分布。通过学习这些分布之间的 OT 映射,并通过可解释的强度参数应用这些映射,AcT 能够诱导所需风格的恰当数量 (见图 5)。

图 5:使用 AcT 对图片风格进行细粒度控制的交互式演示。选择原始图像和要应用的风格,然后使用滑块调整传输强度以查看对生成图像的影响。

不要想到粉红色的大象

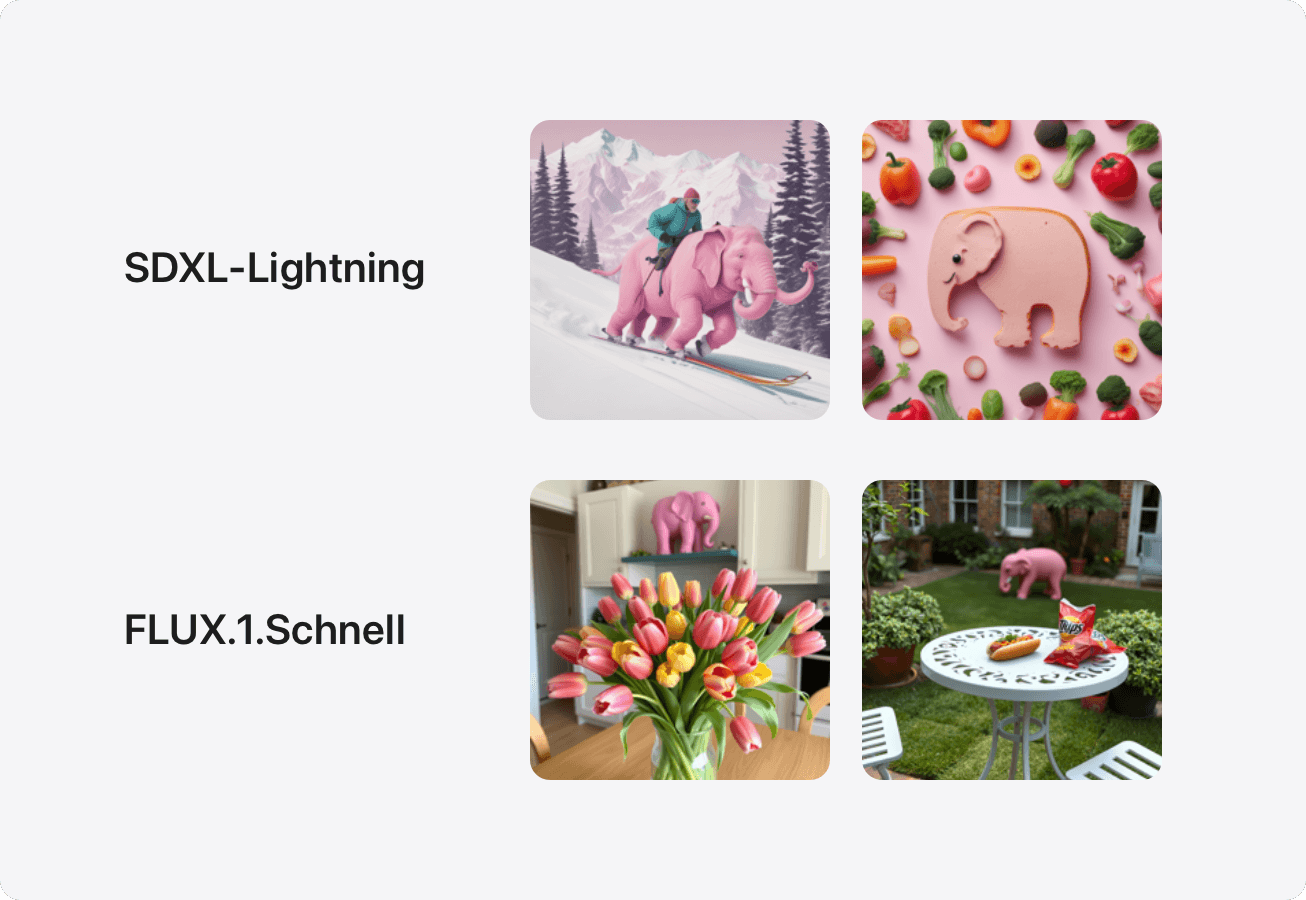

上面的标题很可能会导致读者想到粉红色的大象 - 有趣的是,人们发现 T2I 也会发生同样的现象 (见图 6)。这可能发生在 T2I 的文本编码器将句子嵌入为词袋,并且不够强大,无法解释否定,但通常情况下,在提示词中包含否定指令(例如,“不要出现粉红色的大象”)实际上会导致 T2I 模型在图像中包含该不需要的元素。

图 6:当提示创建不包含粉红色大象的图像时,文本到图像模型(例如 SDXL-Lightning 和 FLUX.1.Schnell)通常会生成包含一个粉红色大象的图像。

Linear-AcT 是一种可以解决此挑战并从生成的图像中删除不需要的概念的干预。为此,需要一组包含要删除的概念的源提示词(例如,“一栋房子和一棵树,旁边有一只粉红色的大象”),以及一组不存在该概念的目标提示词(例如,“一栋房子和一棵树”)。主要思想是“隔离”要删除的概念,作为提示词集之间的主要区别。Linear-AcT 学习从源集到目标集的传输映射,从而产生一种可控的干预,可以删除否定的概念(如“粉红色的大象”),否则该概念会包含在生成的模型中,如图 图 7 所示。

图 7:“一个老年男子沿着斜坡滑雪。没有 {大猩猩,粉红色的大象,白熊}”。当提示不要显式包含这些概念时,从 SDXL-Lightning 中删除概念“大猩猩”(顶部)、“粉红色的大象”(中间)和“白熊”(底部)。每一列显示不同的传输强度 (λ)。最右边的列对应于不会导致图像嘈杂的最高强度(Linear-AcT 的 λ=1 和 ITI 的 λ=4)。

结论

随着生成语言和文本到图像模型的能力和生产部署持续增长,对其输出提供细粒度控制变得越来越重要。虽然像 RLHF 和指令微调这样的常见方法在改善 LLM 输出与用户期望的对齐方面是有效的,但这些方法需要大量的资源,并且随着模型复杂性的增加,它们变得不切实际。Activation Transport (AcT) 提供了对 LLM 和 T2I 扩散模型输出的细粒度控制,而没有 RLHF 和微调的限制。这种根据最优传输理论控制激活值的通用框架与模态无关,并且需要的计算开销可以忽略不计,研究人员和从业人员现在可以使用 AcT 并在此基础上构建,代码可在 这里 获得。