大规模伤害儿童?揭秘 Snapchat 的潜在危害

After Babel

SubscribeSign in

Share this post

After BabelSnapchat is Harming Children at an Industrial Scale

Copy linkFacebookEmailNotesMore

After BabelSnapchat is Harming Children at an Industrial Scale

Copy linkFacebookEmailNotesMore

Snapchat is Harming Children at an Industrial Scale

从他们自己的话语中,我们看到 Snap Inc 的设计选择使数百万儿童面临危害

Jon Haidt

and

Zach Rausch

Apr 16, 2025

188

Jon Haidt

and

Zach Rausch

Apr 16, 2025

188

Share this post

After BabelSnapchat is Harming Children at an Industrial Scale

Copy linkFacebookEmailNotesMore

2856

Share

After BabelSnapchat is Harming Children at an Industrial Scale

Copy linkFacebookEmailNotesMore

2856

Share

Introduction

2024年10月1日,调查记者 Jeff Horwitz 报道 了一个惊人的统计数据,该数据来自针对 Snap Inc. 的一桩诉讼案中引用的一封 Snap Inc. 内部电子邮件,Snap Inc. 是 Snapchat 的所有者。该电子邮件指出,该公司 每月 收到大约 10,000 份关于性勒索的报告,而且这个数字可能“只是该平台上发生的全部滥用行为的一小部分”。

这个统计数据促使我们调查 Snap Inc. 还知道或相信什么关于其产品对用户,特别是青少年(我们估计大约有 1300 万美国 13-17 岁的青少年使用 Snapchat)。在过去的几个月中,我们审查了多起针对 Snap Inc. 提起的诉讼,其中许多涉及严重或致命的伤害,这些伤害(据称)是由于 Snapchat 的功能造成的。从 2022 年到 2025 年,作为针对社交媒体被告的多区诉讼(Multidistrict Litigation,MDL)和司法委员会协调程序(Judicial Council Coordinated Proceedings,JCCP)的一部分,有 600 多起1此类诉讼明确将 Snap Inc. 列为被告。此外,内华达州Nevada和新墨西哥州New Mexico的州检察长已经对该公司提起了重大诉讼——我们将在本文中大量引用这两起案件。

按照我们之前关于归因于 TikTok 的“工业规模危害”的文章“industrial scale harms” attributed to TikTok的形式,本文展示了数十条引文,这些引文来自内部报告、研究、备忘录、对话和公开声明,其中 Snap 的高管、员工和顾问承认并讨论了 Snapchat 对许多使用其平台的未成年人造成的危害。我们将这些发现分为五个关键的危害群组:

- 令人上瘾、强迫性和有问题的用法

- 毒品和枪支

- 儿童性虐待材料(Child Sexual Abuse Material,CSAM)、性勒索和面对面的性侵犯和袭击

- 网络欺凌

- 对危害和未成年人使用的知情,以及缺乏行动

与 TikTok 类似,我们表明,公司内部人士知道多种广泛而严重的危害,并且在许多情况下没有迅速采取行动或做出实质性改变。正如 Snap 的安全工程主管所说,关于在 Snap 上销售毒品或儿童性虐待材料的安卓[Android]用户:

“没关系,已经坏了十年了,今晚我们可以容忍。”2

关于该平台上的性勒索,一位员工在私人频道中抱怨:

“上帝,我非常生气,我们现在被这种性勒索的烂事搞得不堪重负。我们整个 f...ing 一年都在袖手旁观,束手无策。”3

简报称,该公司还意识到未成年人使用猖獗,并且其年龄限制过程无效。Snap 的高管承认 Snapchat 的年龄验证系统

“在阻止未成年用户注册 Snapchat 应用方面实际上毫无用处。”4

尽管下面的证据都是公开可用的,但没有人汇编和组合来自公司内部人士和内部报告的直接引文,这些引文涉及多种声称的危害。我们认为这种汇编为父母提供了重要信息,他们可能想深入了解一家托管他们孩子社交生活、占据他们大部分注意力并影响他们社交发展的公司的商业行为。

在每个部分的开头,我们都会重点介绍一个真实案例——从相关的法庭文件中提取——说明所讨论的具体危害。每个孩子的故事都提供了对更广泛的统计数据和引文的人性化视角,这些统计数据和引文揭示了公司内部讨论的深远危害。 Subscribe

1. 我们与 Snap, Inc. 的对话

在撰写本文时,我们与 Snap 的领导人和员工进行了四次对话,在对话中我们向他们询问了各种简报中出现的一些危害。在其中三次会议中,我们专门询问了来自新墨西哥州[New Mexico]简报中引用的一封 Snap 内部电子邮件的说法,即 Snap 每月收到 10,000 份性勒索报告。我们没有收到任何反驳或对该说法的解释。

Snap 的信任和安全团队提出了一点,我们认为这一点是有效且重要的,读者应该记住:我们引用的简报提出了诉讼一方的指控,并且通常还有另一方。一些引文可能被误解或断章取义。Snap 的信任和安全团队向我们指出了一项 动议,Snap 提出要求驳回新墨西哥州[New Mexico]的案件。我们阅读了该简报,发现它仅对新墨西哥州[New Mexico]简报中提出的许多主张中的少数几个提出了异议。其中两项主张已在我们的引文列表中,因此我们从下面的文章中删除了一个,并在另一个中添加了一条评论。

Snap 的信任和安全团队还分享了他们为减轻对儿童和青少年的危害而采取的各种措施。信任和安全团队表示,儿童安全是他们的首要任务,他们告诉我们,他们主动删除了大量有害内容。在 Snap 的 驳回动议 中,他们表示,自 2020 年以来,Snap“信任和安全团队的规模翻了一番,执法运营团队的规模扩大了两倍”,这“提高了 Snap 在 Snapchat 用户报告该平台上的骚扰或不当性内容时迅速采取行动的能力”。

我们毫不怀疑 Snap 确实从其平台上删除了大量有害内容,或者他们正在努力删除更多内容。但是,很难评估 Snap 正在解决问题的 5%,75%还是 99%,因为它的指标侧重于删除的内容数量,而不是在平台上遭受危害的 Snapchat 用户百分比。即使 Snap 每年删除十亿条与毒品或性相关的内容,许多青少年用户可能仍然每天遇到此类内容。而且任何想购买毒品的青少年仍然可以轻松找到经销商,这在许多 悲剧案例(包括非常近期的案例)中已经发生。许多人可能仍然报告看到性内容,因为用户有很多方法可以在不违反政策的情况下进行性暗示。

从父母的角度来看:如果您要选择将您的青少年送到哪个夏令营,得知一个营地过去每月从其沿海游泳区移除 100 条鲨鱼,但现在他们每月移除 500 条鲨鱼,这会让人放心吗?可能根本不让人放心。作为父母,您更喜欢一个将资源投入到预防中的营地——例如通过在游泳区周围设置有效的鲨鱼屏障——而不是一个专注于在露营者报告看到他们的鳍后更快地捕捉鲨鱼的营地。

我们也有机会与他们的领导层和信任与安全团队讨论我们对 Snapchat 功能的许多观察。我们感谢他们愿意与我们互动。我们向他们提出了一些设计变更建议,我们认为这些变更将使该平台不那么容易上瘾且危害更小:

- 为未成年人移除“快速添加”功能5,这是成年捕食者和毒贩接触青少年的主要方式之一。

- 移除“连续快照”功能6,这导致许多青少年强迫性地相互发送照片,不必要地增加了他们在应用上的时间。

- 为未成年人移除美颜滤镜

- 至少对于未成年用户,移除基于参与度的算法。

- 停止删除 Snap 自身服务器上的帖子。Snap 不存储对话内容(超过有限的时间)这一事实有助于毒贩、性勒索者和其他有犯罪意图的人,但即使发生可怕的事情,他们的对话也无法被执法人员发现,这并不能改善大多数儿童的用户体验。

- 采取更多措施来移除未成年用户。Snap 在中学中被广泛使用。(常识媒体[Common Sense Media]在 2021 年进行的一项调查 报告称,13% 的 8 至 12 岁的儿童说他们“曾经使用过” Snapchat。因此,我们估计,在 2021 年,美国大约有 270 万 8 至 12 岁的儿童使用过 Snapchat。)

我们提出的一个更广泛的要求是合作进行公开可访问的用户体验研究,这有助于量化和减少我们在下面描述的危害。重要的是要准确地知道有多少比例的孩子在其平台上收到不想要的侵犯,或者知道如何获得毒品 - 这与他们通常公开回答的问题非常不同。公司举报人company whistleblowers 和 公共卫生专家 都呼吁进行此类评估。

我们仍然希望 Snap 将对其中一些要求采取行动。尽管如此,我们决定继续发布这篇文章,因为无论近年来取得了哪些安全改进,以及 Snap 表示它将在未来做出哪些改进,我们认为公众了解与 Snapchat 相关的危险仍然至关重要,正如 Snap 自己的员工和顾问所表达的那样,他们被引用在近年来出现的众多法庭文件中。

虽然该公司显然已努力解决其中一些问题,但对于我们这些试图理解的人来说,透明地了解他们过去的行动以及内部人士对该平台影响的看法至关重要:我们是如何走到这一步的?在 2010 年代初期到底发生了什么,以至于现在出现了 国际青年心理健康危机,越来越多的证据表明 注意力分散 和 功能性智力下降,以及无数的严重伤害案例——从在 Snapchat 上购买的掺有芬太尼的毒品到在他们的平台上开始的性勒索后的自杀。

我们在下面给出的引文表明,发生在 Snapchat 上的危害(与 TikTok 和 Instagram) 一样,非常广泛,即使是一个高度敬业的信任和安全团队删除了数亿条有害内容,也无法阻止数百万儿童在其平台上遭受严重危害。这就是为什么迫切需要进行设计更改。更好的内容审核是不够的。

以下是一种简单的确定在线平台对儿童是否安全的方法:它是否将儿童与匿名的、未经验证的成年陌生人联系起来?如果是这样,那么很可能会出现各种各样的危害,父母应该警惕让他们的孩子使用该平台,直到该公司做出非常重大的设计更改。 Share

2. 我们从 Snap 获得的内容

我们主要参考了新墨西哥州[New Mexico]检察长 Raul Torrez 于 2024 年 10 月 2 日发布的针对 Snap Inc. 的 165 页略微经过编辑的投诉。我们还参考了内华达州[The State of Nevada]检察长 Ford 及其同事的投诉以及民事诉讼第二次修订的投诉 Neville et al. v. Snap 中的内部证据。

我们创建了三个简报的注释版本(新墨西哥州[New Mexico]、内华达州[Nevada] 和 Neville et al.)7,以便您可以在其余简报的上下文中查看我们选择的每个选段。

还有各种较小的个人和集体诉讼,这些诉讼解决了 Snapchat 的特定功能如何对个别未成年用户造成特定危害。虽然我们不依赖这些诉讼来获取公司的内部引文,但它们提供了受到该平台伤害的家庭的证词。8

在本文的其余部分,我们组织了目前可用的危害证据,这些证据直接来自 Snap Inc. 的员工和领导以及他们委托的报告。 Leave a comment

3. 他们认为或知道他们造成的危害

[[请注意,在本节中,粗体文本是公司员工、顾问、高管和内部备忘录的直接引文。非粗体文本是从指定 AG 简报的指定部分复制的直接引文,这些引文设置了来自公司内部人士的相关引文。双中括号中的斜体文本是我们——Jon 和 Zach 的注释。请注意,我们在每个危害群组的开头都包含真实案例的简短摘要。这些是由 Zach 和 Jon 撰写的,借鉴了法庭文件的引文。对于每种危害,我们都从上面讨论的各种简报中提取。]]

危害群组 1:令人上瘾、强迫性和有问题的用法

[[根据简报,Snap Inc. 设计其平台旨在最大限度地提高未成年人的参与度和花费的时间——从而导致未成年人出现有问题的社交媒体使用。这是通过推送通知、Snapstreaks、Snap Stories 等功能完成的。9。]]

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

- *. [[在每个危害群组中,我们首先讲述一起针对 Snap 提起的诉讼中出现的孩子的故事。我们通过直接引用分享他们的经历,有时还会总结法律简报中的关键细节。为了便于阅读,我们不包括这些故事的斜体或括号]]

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

真实案例:以下事实在公开投诉 Neville v. Snap P. 117-124, PARA 481-517 中被指控:Jack McCarthy 在 12 岁时得到了他的第一部手机,并在父母不知情或未经同意的情况下开设了一个 Snapchat 账户。杰克使用 Snapchat “与其心理健康的稳定下降同时发生”。杰克“按计划被锁定在 Snap 的社交媒体产品中,使他感觉没有它就无法入睡”。当他的父母试图限制他对 Snapchat 的访问时,杰克“变得烦躁……他会变得明显恐慌和不理智,愿意做和说任何事情来取回他的设备”。尽管杰克的睡眠和焦虑加剧,但他声称如果没有手机在他身边,他的“失眠”会变得更糟。在杰克心理健康状况下降多年并越来越依赖 Snap 平台后,杰克通过 Snapchat 上的一个匿名经销商获得了毒品,该经销商通过 Snap 的“快速添加”和地图功能添加了他。2021 年 9 月 25 日早上,人们发现杰克死在他家的厨房地板上。

2025 年 3 月 22 日,我们通过电子邮件与杰克的母亲进行了联系。她解释说,“杰克死于芬太尼中毒而不是过量。杰克服用了一颗药丸,但他不知道这颗药丸含有芬太尼……足以杀死四个人的芬太尼。杰克从一开始就没有机会。”

(March 16, 2002 - September 25, 2021)

(March 16, 2002 - September 25, 2021)

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

- *.

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

-

内部证据

新墨西哥州[New Mexico](NM)

-

NM P. 111, PARA 273

- 在 2017 年 1 月,一封标题为 “Snapstreak 分布初窥” 的内部电子邮件重点介绍了 Snap 员工关于 Snapstreak 的一些评论:

- “哇,我们应该添加更多像这样的令人上瘾的功能。”

- “我认为调查 Snapstreak 会话对用户有多健康会很有趣……如果我打开 Snapchat,拍一张天花板的照片来保持我的 streak,并且不与应用的其余部分互动,这是我们想要鼓励的行为类型吗?或者,如果我们发现 streak 令人上瘾,或者是深入参与 Snapchat 其他部分的门户,那么对于“健康”的长期保留和与产品的互动来说,这将是一件积极的事情。”

- “我们 70% 的 DAU 每天访问该应用,但只有 22% 的人正在 streak。”

- “大多数 streaker 是我们的核心人口。”

- “我们应该在最高级别回答,streak 是高参与度的副产品还是驱动因素。我的直觉是,它一开始是前者,但最终会成为后者 - 我们应该弄清楚这种神奇的转变点何时发生。”

- 在 2017 年 1 月,一封标题为 “Snapstreak 分布初窥” 的内部电子邮件重点介绍了 Snap 员工关于 Snapstreak 的一些评论:

-

NM P. 112, PARA 27610

- 一个 2018 年 12 月的题为 “了解消费者和 Snapchat Discover” 的演示文稿概述了在线调查和焦点小组的发现。摘要指出,“Streak 已经变得充满压力……” 并包括了关于用户害怕错过(FOMO)的数据:

- “作为真正的数字原生代,Z 世代将他们的移动设备视为自己的延伸,虽然这允许持续访问,但它也带来了持续的压力。永远不会摆脱真实存在的 FOMO。”

- “小组中的受访者和通过社交媒体日记表达,如果他们没有不断地查看社交媒体,他们会觉得他们“错过”了一些东西(内容、来自朋友的交流、新闻等)。”

- “45% 的 Snapchat 用户 13-17 岁“几乎一直”使用 Snapchat”

- “41% 的 Snapchat 用户 13-17 岁“几乎一直”使用 Youtube”

- “34% 的 Snapchat 用户 13-17 岁“几乎一直”使用 Instagram”

- 一个 2018 年 12 月的题为 “了解消费者和 Snapchat Discover” 的演示文稿概述了在线调查和焦点小组的发现。摘要指出,“Streak 已经变得充满压力……” 并包括了关于用户害怕错过(FOMO)的数据:

-

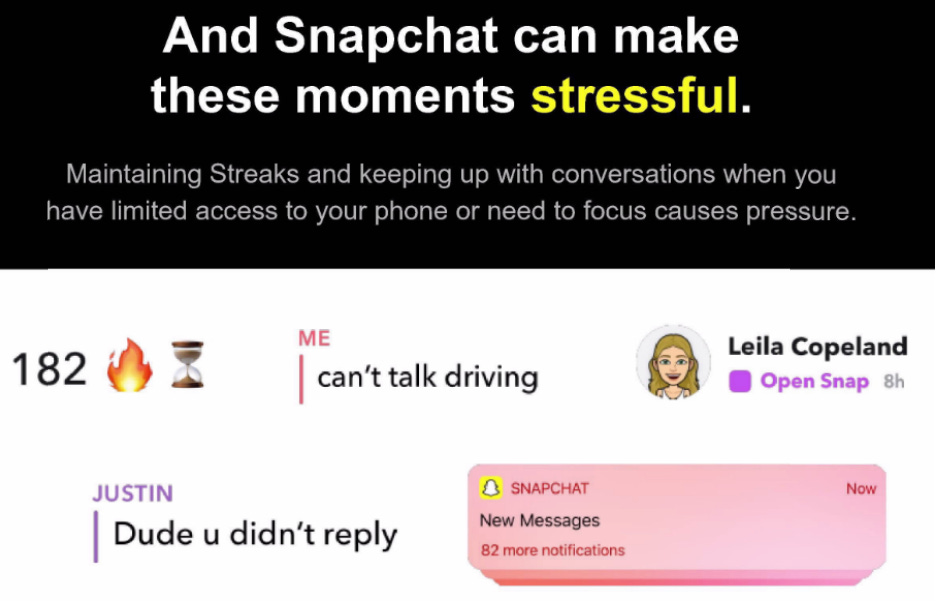

NM P. 113, PARA 278:在 2019 年 10 月,一个演示文稿承认 “Streak 让人无法即使一天也断开连接” 并且 “保持 Streak 并跟上对话……会导致压力,” 这种压力因通知而加剧,会带来压力:(图 42)

内华达州[Nevada](NV)

-

NV P. 24, PARA 63

- 在课堂上干扰性地使用 Snapchat 对被告来说并不意外。在 Snapchat 网站上的第一篇文章中,被告表示他们对这些干扰“感到激动”:

- “[t]为了更好地了解人们如何使用 Snapchat 以及我们可以做些什么来使其更好,我们联系了一些用户。我们很高兴听到他们中的大多数是高中生,他们将 Snapchat 用作在课堂上传递纸条的新方式——整天都在来回发送老师的背后照片和有趣的表情” [[您仍然可以在 Snap 的网站上找到此引文。引文继续如下:“服务器数据支持了这一点,我们看到在学校期间活动高峰,在周末活动下降。”]]

- 在课堂上干扰性地使用 Snapchat 对被告来说并不意外。在 Snapchat 网站上的第一篇文章中,被告表示他们对这些干扰“感到激动”:

-

NV P. 51-52, PARA 157

- 例如,在 2018 年,被告对 SnapStreak 进行了内部研究,发现超过三分之一的用户报告说,保持 Snap Streak 的活跃“非常”或“极其重要”,并且用户进一步报告说,他们在保持 Streak 活跃时经历的压力水平“很大”甚至“无法忍受”。

-

NV P. 52, PARA 158

- 同样,其他内部研究表明,Snapchat 用户在使用该平台时更具强迫性,与它互动“**在我醒来时”,“在上班/上学之前”,“在上班/上学期间”,“在上班/上学之后”,“在度假时”**和“当我与其他人在一起时。”

Subscribe

危害群组 2:毒品和枪支

*[[根据简报,Snap 上广泛存在暴力