AI assisted search-based research works now

AI辅助的搜索式研究终于可行了

Simon Willison’s Weblog

AI辅助的搜索式研究现在真的有效了

2025年4月21日

在过去的两年半里,我最希望从 LLM 获得的功能是代表我执行基于搜索的研究任务。早在 2023 年初,我们就看到了最初的曙光,当时出现了 Perplexity(最初于2022 年 12 月推出,第一个 prompt 泄露于 2023 年 1 月)以及由 GPT-4 驱动的 Microsoft Bing(于2023 年 2 月推出/惨败)。从那时起,很多人都尝试解决这个问题,最值得注意的是 Google Gemini 和 ChatGPT Search。

2023 年代的版本很有希望,但非常令人失望。它们非常容易捏造搜索结果中不存在的细节,以至于你无法信任它们告诉你的任何信息。

在 2025 年上半年,我认为这些系统终于越过了变得真正有用的界限。

- 来自三个不同供应商的 Deep Research

- o3 和 o4-mini 在搜索方面非常出色

- Google 和 Anthropic 需要赶上

- 通过搜索懒惰地将代码移植到新的库版本

- 现在 Web 的经济模式如何运作?

来自三个不同供应商的 Deep Research #

首先是 Deep Research 的实现——Google Gemini 和 OpenAI 以及 Perplexity 都推出了具有该名称的产品,它们都令人印象深刻:它们可以接受查询,然后持续运行几分钟,组装一份冗长的报告,其中包含数十个(有时是数百个)引用。几周前,Gemini 的版本进行了 巨大的 升级,当时他们将其切换为使用 Gemini 2.5 Pro,从那时起,我从中获得了一些出色的结果。

等待几分钟才能获得 10 多页的报告并不是我理想的此类工具的工作流程。我没有耐心,我希望更快地得到答案!

o3 和 o4-mini 在搜索方面非常出色 #

上周,OpenAI 通过 ChatGPT 发布了支持搜索的 o3 和 o4-mini。从表面上看,这些看起来与我们已经看到的想法相同:LLM 可以选择调用搜索工具作为回复 prompt 的一部分。

但有一个 非常重要的 区别:这些模型可以在生成最终答案之前,运行搜索,作为其思维链推理过程的一部分。

事实证明,这是一件 非常重要 的事情。我一直在向 ChatGPT(以 o3 或 o4-mini 模式)提出各种问题,并获得了真正有用的、基于搜索结果的答案。我还没有发现任何捏造的细节,而且与以前的系统不同,当我看到它们在做什么时,我很少对着屏幕大喊“不,不要搜索 那个!”。

以下是最近的四个示例记录:

- 获取包括 RTX 5090 和 RTX PRO 6000 的 VRAM 在内的规格——以及发布日期和价格

- 为我找到一个网站工具,我可以将 URL 粘贴到其中,它可以为我提供字数统计和估计阅读时间

- 弄清楚 ChatGPT 正在为 o3 和 o4-mini 使用什么搜索引擎

- 查找 Cloudflare r2 定价,并使用 Python 计算出此(仪表板截图)的成本

与 o3 交谈感觉就像与 Deep Research 工具实时交谈,而无需等待几分钟才能生成过于冗长的报告。

我的预感是,要做好这一点,需要一个非常强大的推理模型。评估搜索结果很困难,因为需要筛选大量垃圾邮件和欺骗性信息。先前实现的令人失望的结果通常归结为 Web 上充斥着垃圾信息。

也许 o3、o4-mini 和 Gemini 2.5 Pro 是第一批跨越了 gullibility-resistance 阈值的模型,以至于它们可以有效地做到这一点?

Google 和 Anthropic 需要赶上 #

面向用户的 Google Gemini 应用程序也可以搜索,但它不会向我显示它正在搜索什么。因此,我只是不信任它。这是一个巨大的错失机会,因为 Google 大概拥有迄今为止最好的搜索索引,所以他们真的应该能够构建一个很棒的版本。而且 Google 在其常规搜索界面上的 AI 辅助搜索会 疯狂地 捏造信息,以至于它正在积极损害他们的品牌。我刚刚检查过,Google 仍然在显示关于 Encanto 2的胡说八道!

Claude 也在一个月前终于添加了网络搜索,但感觉没有那么好。它使用的是 Brave 搜索索引,我认为它不如 Bing 或 Gemini 全面,而且搜索不会作为强大的推理流程的一部分进行。

通过搜索懒惰地将代码移植到新的库版本 #

对我来说,真正神奇的时刻是几天前。

我的 Gemini 图像分割工具 使用了 @google/generative-ai 库,该库已被大声弃用,取而代之的是仍在预览中的 Google Gen AI SDK @google/genai 库。

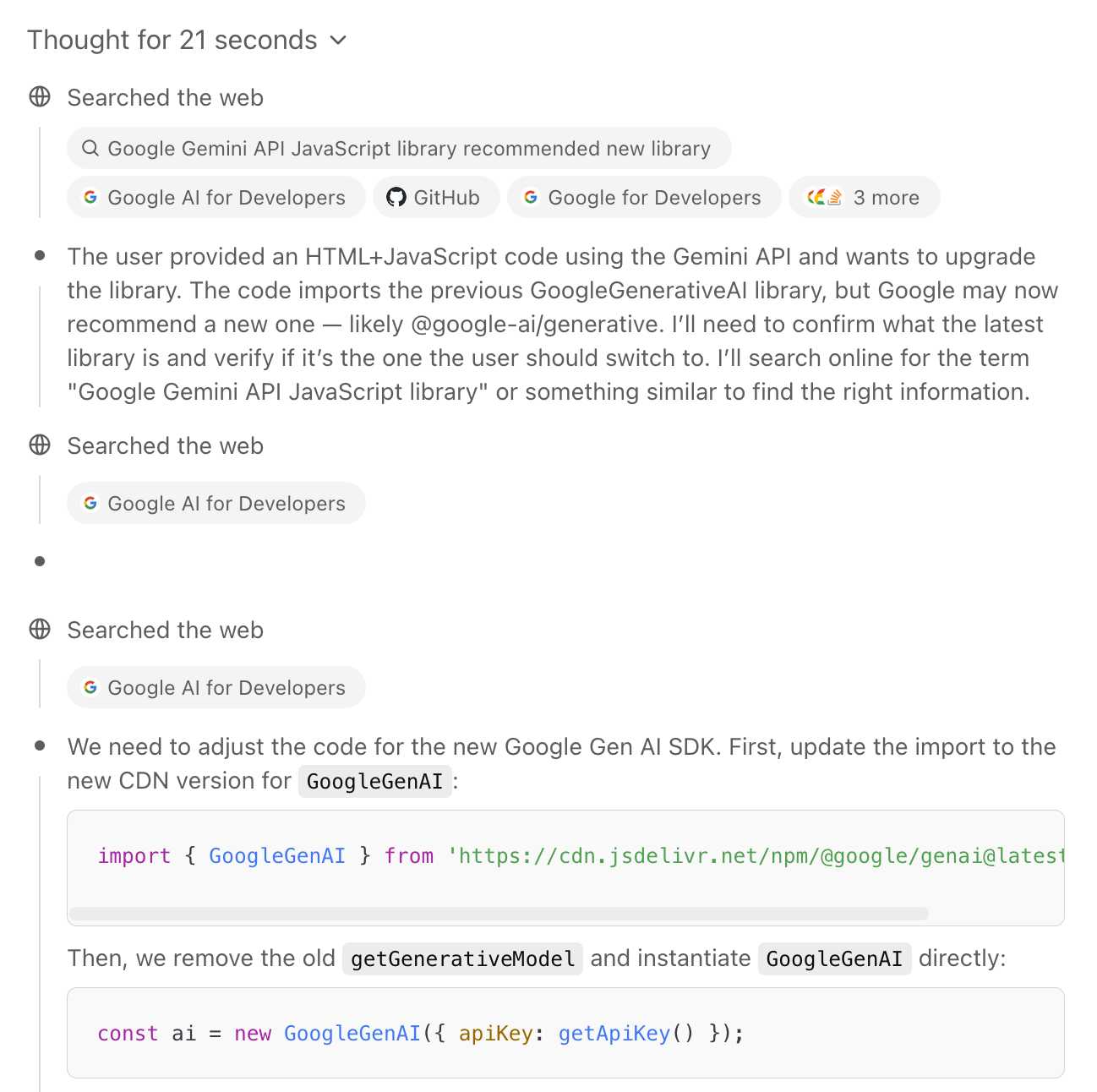

我 不 想做升级工作。一时兴起,我将我的完整 HTML 代码(带有内联 JavaScript)粘贴到 ChatGPT o4-mini-high 中,并提示:

此代码需要升级到 Google 推荐的新的 JavaScript 库。弄清楚那是什么,然后查找足够的文档来将此代码移植到它。(我甚至懒得自己查找新库的名称!)

... 它完全做到了。它运行了 21 秒的思考,运行了一堆搜索,弄清楚了新库(它存在于其训练截止日期 之外),找到了升级说明 并生成了 一个新版本我的代码,并且运行良好。

我出于闲着的好奇心在做其他事情时在手机上运行了这个 prompt。当它完全按照我需要的做时,我感到 非常 惊讶和印象深刻。

现在 Web 的经济模式如何运作? #

我今天写这篇文章是因为它已经成为我两年多来的“LLM 能够可靠地做到这一点吗?”问题之一。我认为它们刚刚跨越了变得可以用作研究助理的界限,而无需感觉到需要用放大镜检查它们所说的一切。

我仍然不相信它们不会犯错,但我认为我可能足够信任它们,以至于我会跳过对低风险任务的自己的事实核查。

这也意味着我们在过去几年中预测的一系列潜在的黑暗未来更有可能成为现实。如果你可以直接从聊天机器人那里获得答案,为什么要访问网站呢?

对此的诉讼早在 LLM 仍然主要是垃圾的时候就开始了。现在它们实际上擅长此事,风险要高得多!

我已经感觉到我对 Google 搜索的使用正在直线下降。我预计,随着 Web 的新经济模式摇摇晃晃地出现,将会有一段颠簸的旅程。 Posted 21st April 2025 at 12:57 pm · Follow me on Mastodon, Bluesky, Twitter or subscribe to my newsletter

更多近期文章

- 也许 Meta 的 Llama 声称是开源的,因为欧盟 AI 法案 - 2025年4月19日

- 使用 Gemini 2.5 进行图像分割 - 2025年4月18日

This is AI assisted search-based research actually works now by Simon Willison, posted on 21st April 2025. Part of series How I use LLMs and ChatGPT

- Building Python tools with a one-shot prompt using uv run and Claude Projects - Dec. 19, 2024, 7 a.m.

- Here's how I use LLMs to help me write code - March 11, 2025, 2:09 p.m.

- Not all AI-assisted programming is vibe coding (but vibe coding rocks) - March 19, 2025, 5:57 p.m.

- AI assisted search-based research actually works now - April 21, 2025, 12:57 p.m.

google 359 search 88 ai 1230 openai 283 generative-ai 1057 chatgpt 145 llms 1047 anthropic 135 perplexity 5 gemini 80 llm-tool-use 29 llm-reasoning 42 o3 15 deep-research 5 ai-ethics 153 ai-assisted-search 26

Previous: Maybe Meta's Llama claims to be open source because of the EU AI act

On-Demand H100 SXM GPUs for $3.49/hr/GPU with Lambda 640 GB of vRAM in one 8x instanceLaunch now

lambdalabs.com

Ads by EthicalAds

On-Demand H100 SXM GPUs for $3.49/hr/GPU with Lambda 640 GB of vRAM in one 8x instanceLaunch now

lambdalabs.com

Ads by EthicalAds