AI 对齐问题:一个比例模型

AI 对齐问题:一个比例模型

2025年5月22日

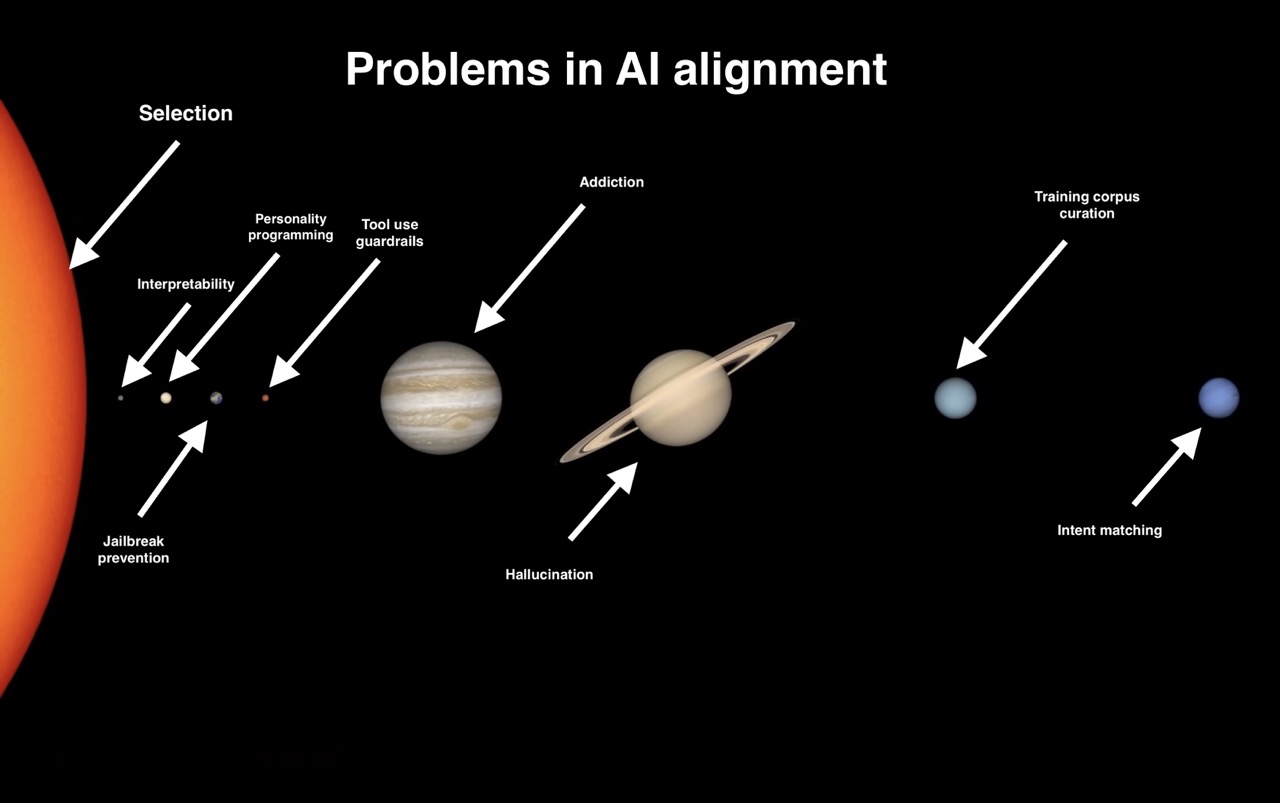

在试图理解 AI 对齐对话中困扰我的问题时,我最终以一种千禧年的方式,用一个 meme 来表达:

解释:

Wikipedia 上关于 AI Alignment 的文章将其定义如下:

在人工智能 (AI) 领域,对齐旨在引导 AI 系统朝着个人或团体的预期目标、偏好或道德原则发展。

我们可以观察到:我们也希望引导其他事物的发展,例如汽车运输、社交媒体、药品或学校课程,“朝着个人或团体的预期目标、偏好或道德原则发展”。

为什么没有“药品对齐”或“学校课程对齐”的 Wikipedia 页面呢?

我认为答案是“AI Alignment”隐含着一种技术倾向。 例如,如果您访问 AI Alignment Forum,您会发现更多的数学,而不是孔子或福柯。

另一方面,没有人会将“药品对齐”(如果将其表述为“[引导]药品系统朝着个人或团体的预期目标、偏好或道德原则发展”)主要视为数学或科学问题。

虽然制药开发人员总能在实验室内部做一些事情来至少尝试促进道德原则——例如,或许可以尽量减少可预防的危害,即使没有强制这样做——但我们也接受,道德工作在很大程度上是在实验室之外完成的;在购买决策中,在药品市场运作方式中,在医疗-工业-政府综合体的巨大混乱中。 这是一个如此分散的问题,以至于很难将其全部集中到一个连贯的百科全书条目中。

世界其他地方通过购买、分析、监管、讨论等方式影响行业方向的过程就是选择(Selection)。 这来自进化的术语——在这种框架下,恐龙不是仅仅决定开始长出翅膀并飞翔; 大自然选择了鸟类来填补侏罗纪时期新的生态位。

虽然大自然不能以道德为依据进行选择,但我们可以,而且确实这样做了,当我们选择什么样的公司和规则以及权力中心正在填补我们世界的哪些生态位时。 这是一个去中心化的运作(就像进化一样),不受任何单个实体的控制,而是由托尔斯泰所说的“大众意志的总和”组成。

技术性的 AI 对齐问题(由 meme 中的行星代表)固然重要,但实验室外发生的事情要重要得多; AI 只是世界经济的一小部分; 然而 AI 几乎触及我们所有人。 我想说的是,我们选择 如何 让 AI 触及我们的方式,是 AI 对齐的重大问题。 如果您总体上关心 AI 对齐,那么忽视它是一种愚蠢的行为。

为了辩护,一个否认选择的人可能会争辩说,在引导“大众意志的总和”朝着“群体的预期目标、偏好或道德原则”方面,没有取得任何进展。 但这将相当于拒绝 Categorical Imperative,以及博弈论中所有有趣的(通常非常数学的)问题,放弃人性,只有失败者才会这样做。

一种可以应用于提高选择效率的社会技术协议是:https://muldoon.cloud/2025/03/08/civic-organizing.html。 但还有很多其他的。 这是 AI 对齐的重大工作。 meme 就是这么说的。